diff --git a/http/http3.md b/http/http3.md

index 69ee764..4d41d65 100644

--- a/http/http3.md

+++ b/http/http3.md

@@ -1,173 +1,173 @@

-- [HTTP3 \& QUIC Protocols](#http3--quic-protocols)

- - [What is HTTP3](#what-is-http3)

- - [TCP/IP模型中HTTP3 vs QUIC](#tcpip模型中http3-vs-quic)

- - [QUIC Protocol](#quic-protocol)

- - [What is QUIC Used For](#what-is-quic-used-for)

- - [HTTP/1.1 vs HTTP/2 vs HTTP/3: Main differences](#http11-vs-http2-vs-http3-main-differences)

- - [Best Features of HTTP/3 and QUIC](#best-features-of-http3-and-quic)

- - [QUIC handshake](#quic-handshake)

- - [0-RTT on Prior Connections](#0-rtt-on-prior-connections)

- - [Head-of-Line Blocking Removal](#head-of-line-blocking-removal)

- - [HOL blocking术语](#hol-blocking术语)

- - [How does QUIC remove head-of-line blocking](#how-does-quic-remove-head-of-line-blocking)

- - [Flexible Bandwidth Management](#flexible-bandwidth-management)

- - [Pre-Stream Flow Control](#pre-stream-flow-control)

- - [拥塞控制算法](#拥塞控制算法)

-

-

-# HTTP3 & QUIC Protocols

-http3旨在通过QUIC(下一代传输层协议)来令网站更快、更安全。

-

-在协议高层,http3提供了和http2相同的功能,例如header compression和stream优先级控制。然而,在协议底层,QUIC传输层协议彻底修改了web传输数据的方式。

-

-## What is HTTP3

-HTTP是一个应用层的网络传输协议,定义了client和server之间的request-reponse机制,允许client/server发送和接收HTML文档和其他文本、meidia files。

-

-http3最初被称为`HTTP-over-QUIC`,其主要目标是令http语法及现存的http/2功能能够和QUIC传输协议兼容。

-

-故而,`HTTP/3`的所有新特性都来源于QUIC层,包括内置加密、新型加密握手、对先前的连接进行zero round-trip恢复,消除头部阻塞问题以及原生多路复用。

-

-## TCP/IP模型中HTTP3 vs QUIC

-通过internet传输信息是复杂的操作,涉及到软件和硬件层面。由于不同的设备、工具、软件都拥有不同的特性,故而单一协议无法描述完整的通信流程。

-

-故而,网络通信是已于通信的协议栈实现的,协议栈中每一层职责都不同。为了使用网络系统来通信,host必须实现构成互联网协议套件的一系列分层协议集。通常,主机至少为每层实现一个协议。

-

-而HTTP则是应用层协议,令web server和web browser之间可以相互通信。http消息(request/reponse)在互联网中则是通过传输层协议来进行传递:

-- 在http/2和http/1.1中,通过TCP协议来进行传递

-- 在`http/3`中,则是通过QUIC协议来进行传递

-

-> `QUIC`为http/3新基于的传输层协议,之前http都基于tcp协议进行传输

-

-## QUIC Protocol

-`QUIC`协议是一个通用的传输层协议,其可以和任意兼容的应用层协议来一起使用,HTTP/3是QUIC的最新用例。

-

-`QUIC`协议基于`UDP`协议构建,其负责server和client之间应用数据的物理传输。UDP协议是一个简单、轻量的协议,其传输速度高但是缺失可靠性、安全性等特性。QUIC实现了这些高层的传输特性,故而可以用于优化http数据通过网络的传输。

-

-在HTTP/3中,HTTP的连接从`TCP-based`迁移到了`UDP-based`,底层的网络通信结构都发生了变化。

-

-### What is QUIC Used For

-QUIC其创建是同于代替`TCP`协议的,QUIC作为传输层协议,相比于TCP更加灵活,性能问题更少。QUIC协议继承了安全传输的特性,并且拥有更快的adoption rate。

-

-QUIC协议底层基于UDP协议的原因是`大多数设备只支持TCP和UDP的端口号`。

-

-除此之外,`QUIC`还利用了UDP的如下特性:

-- UDP的connectionless特性可以使其将多路复用下移到传输层,并且基于UDP的QUIC实现并不会和TCP协议一样存在头部阻塞的问题

-- UDP的间接性能够令QUIC重新实现TCP的可靠性和带宽管理功能

-

-基于QUIC协议的传输和TCP相比是完全不同的方案:

-- 在底层,其是无连接的,其底层基于UDP协议

-- 在高层,其是`connection-oriented`的,其在高层重新实现了TCP协议中连接建立、loss detection等特性,从而确保了数据的可靠传输

-

-综上,QUIC协议结合了UDP和TCP两种协议的优点。

-

-除了上述优点外,QUIC还`在传输层实现了高级别的安全性`。QUIC集成了`TLS 1.3`协议中的大部分特性,令其和自身的传输机制相兼容。在`HTTP/3` stack中,encryption并非是可选的,而是内置特性。

-

-TCP, UDP, QUIC协议的相互比较如下:

-| | TCP | UDP | QUIC |

-| :-: | :-: | :-: | :-: |

-Layer in the TCP/IP model | transport | transport | transport |

-| place in the TCP/IP model | on top of ipv4/ipv6 | on top of ipv4/ipv6 | on top of UDP |

-| connection type | connection-oriented | connectionless | connection-oriented |

-| order of delivery | in-order delivery | out-of-order delivery | out-of-order delivery between streams, in order delivery within stremas |

-| guarantee of delivery | guaranteed | no guarantee of delivery | guaranteed |

-| security | unencrypted | unencrypted | encrypted |

-| data identification | knows nothing about the data it transports | knows nothing about the data it transports | use stream IDs to identify the independent streams it transports |

-

-## HTTP/1.1 vs HTTP/2 vs HTTP/3: Main differences

-H3除了在底层协议栈传输层中引入QUIC和UDP协议外,还存在其他改动,具体如图所示:

- -

-HTTP/3-QUIC-UDP stack和TCP-based版本的HTTP最重要的区别如下:

-- QUIC集成了TLS 1.3协议中绝大部分特性,encryption从应用层移动到了传输层

-- HTTP/3在不同的streams间并不会对连接进行多路复用,多路复用的特性是由QUIC在传输层执行的

- - 传输层的多路复用移解决了HTTP/2中TCP中头部阻塞的问题(HTTP/1.1中并不存在头部阻塞问题,因为其会开启多个TCP连接,并且会提供pipelining选项,后来该方案被发现拥有严重实现缺陷,被替换为了HTTP/2中应用层的多路复用)

-

-## Best Features of HTTP/3 and QUIC

-HTTP/3和QUIC的新特性能够令server connections速度更快、传输更安全、可靠性更高。

-

-### QUIC handshake

-在HTTP2中,client和server在执行handshake的过程中,至少需要2次round-trips:

-- tcp handshake需要一次round-trip

-- tls handleshake至少需要一次round-trip

-

-和QUIC则将上述两次handshakes整合成了一个,HTTP3仅需一次round-trip就可以在client和server之间建立一个secure connection。`QUIC可以带来更快的连接建立和更低的延迟。`

-

-QUIC集成了`TLS1.3`中的绝大多数特性,`TLS1.3`是目前最新版本的`Transport Layer Security`协议,其代表:

-- HTTP/3中,消息的加密是强制的,并不像HTTP/1.1和HTTP/2中一样是可选的。在使用HTTP/3时,所有的消息都默认通过encrypted connection来进行发送。

-- TLS 1.3引入了一个`improved cryptographic handshake`,在client和server间仅需要一次round-trip;而TLS 1.2中则需要两次round-trips用于认证

- - 而在QUIC中,则将该`improved cryptographic handshake`和其本身用于连接创建的handshake进行了整合,并替代了TCP的handshake

-- 在HTTP/3中,消息都是在传输层加密的,故而加密的信息比HTTP/1.1和HTTP/2中都更多

- - 在HTTP/1.1和HTTP/2协议栈中,TLS都运行在应用层,故而HTTP data是加密的,但是,TCP header则是明文发送的,TCP header的明文可能会带来一些安全问题

- - 在HTTP/3 stack中,TLS运行在传输层,故而不仅http message被加密,大多数QUIC packet header也是被加密的

-

-简单来说,HTTP/3使用的传输机制相比于TCP-based HTTP版本来说要更加安全。(传输层协议本身的header也被加密)

-

-### 0-RTT on Prior Connections

-对于先前存在的connections,QUIC利用了TLS 1.3的`0-RTT`特性。

-

-`0-RTT`代表zero round-trip time resumption,是TLS 1.3中引入的一个新特性。

-

-TLS session resumption通过复用先前建立的安全参数,减少建立secure connection所花费的时间。当client和server频繁建立连接并断开时,这将带来性能改善。

-

-通过0-RTT resumption,client可以在连接的第一个round-trip中发送http请求,复用先前建立的cryptographic keys。

-

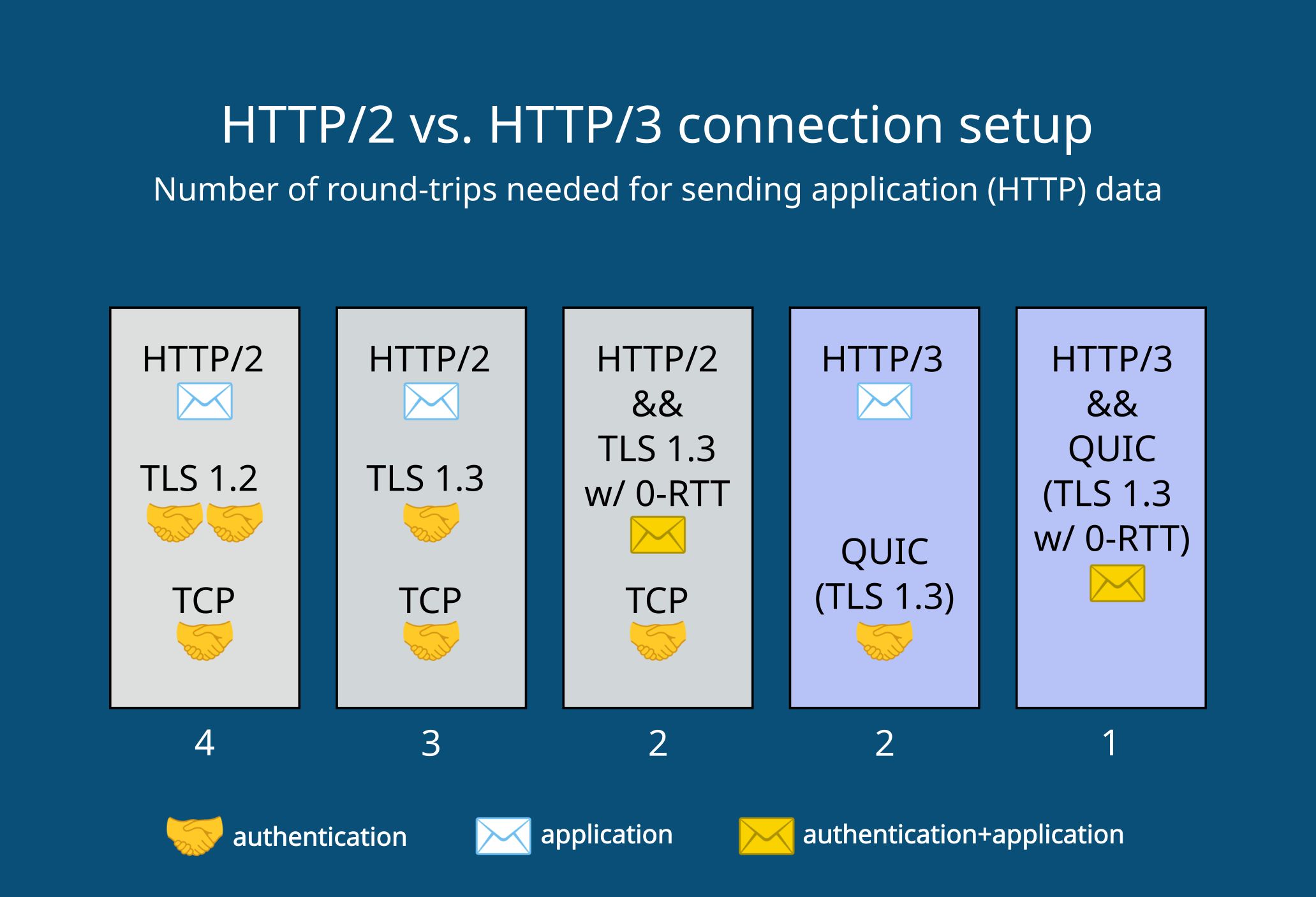

-下面展示了H2和H3 stack在建立连接时的区别:

-

-

-

-HTTP/3-QUIC-UDP stack和TCP-based版本的HTTP最重要的区别如下:

-- QUIC集成了TLS 1.3协议中绝大部分特性,encryption从应用层移动到了传输层

-- HTTP/3在不同的streams间并不会对连接进行多路复用,多路复用的特性是由QUIC在传输层执行的

- - 传输层的多路复用移解决了HTTP/2中TCP中头部阻塞的问题(HTTP/1.1中并不存在头部阻塞问题,因为其会开启多个TCP连接,并且会提供pipelining选项,后来该方案被发现拥有严重实现缺陷,被替换为了HTTP/2中应用层的多路复用)

-

-## Best Features of HTTP/3 and QUIC

-HTTP/3和QUIC的新特性能够令server connections速度更快、传输更安全、可靠性更高。

-

-### QUIC handshake

-在HTTP2中,client和server在执行handshake的过程中,至少需要2次round-trips:

-- tcp handshake需要一次round-trip

-- tls handleshake至少需要一次round-trip

-

-和QUIC则将上述两次handshakes整合成了一个,HTTP3仅需一次round-trip就可以在client和server之间建立一个secure connection。`QUIC可以带来更快的连接建立和更低的延迟。`

-

-QUIC集成了`TLS1.3`中的绝大多数特性,`TLS1.3`是目前最新版本的`Transport Layer Security`协议,其代表:

-- HTTP/3中,消息的加密是强制的,并不像HTTP/1.1和HTTP/2中一样是可选的。在使用HTTP/3时,所有的消息都默认通过encrypted connection来进行发送。

-- TLS 1.3引入了一个`improved cryptographic handshake`,在client和server间仅需要一次round-trip;而TLS 1.2中则需要两次round-trips用于认证

- - 而在QUIC中,则将该`improved cryptographic handshake`和其本身用于连接创建的handshake进行了整合,并替代了TCP的handshake

-- 在HTTP/3中,消息都是在传输层加密的,故而加密的信息比HTTP/1.1和HTTP/2中都更多

- - 在HTTP/1.1和HTTP/2协议栈中,TLS都运行在应用层,故而HTTP data是加密的,但是,TCP header则是明文发送的,TCP header的明文可能会带来一些安全问题

- - 在HTTP/3 stack中,TLS运行在传输层,故而不仅http message被加密,大多数QUIC packet header也是被加密的

-

-简单来说,HTTP/3使用的传输机制相比于TCP-based HTTP版本来说要更加安全。(传输层协议本身的header也被加密)

-

-### 0-RTT on Prior Connections

-对于先前存在的connections,QUIC利用了TLS 1.3的`0-RTT`特性。

-

-`0-RTT`代表zero round-trip time resumption,是TLS 1.3中引入的一个新特性。

-

-TLS session resumption通过复用先前建立的安全参数,减少建立secure connection所花费的时间。当client和server频繁建立连接并断开时,这将带来性能改善。

-

-通过0-RTT resumption,client可以在连接的第一个round-trip中发送http请求,复用先前建立的cryptographic keys。

-

-下面展示了H2和H3 stack在建立连接时的区别:

-

- -

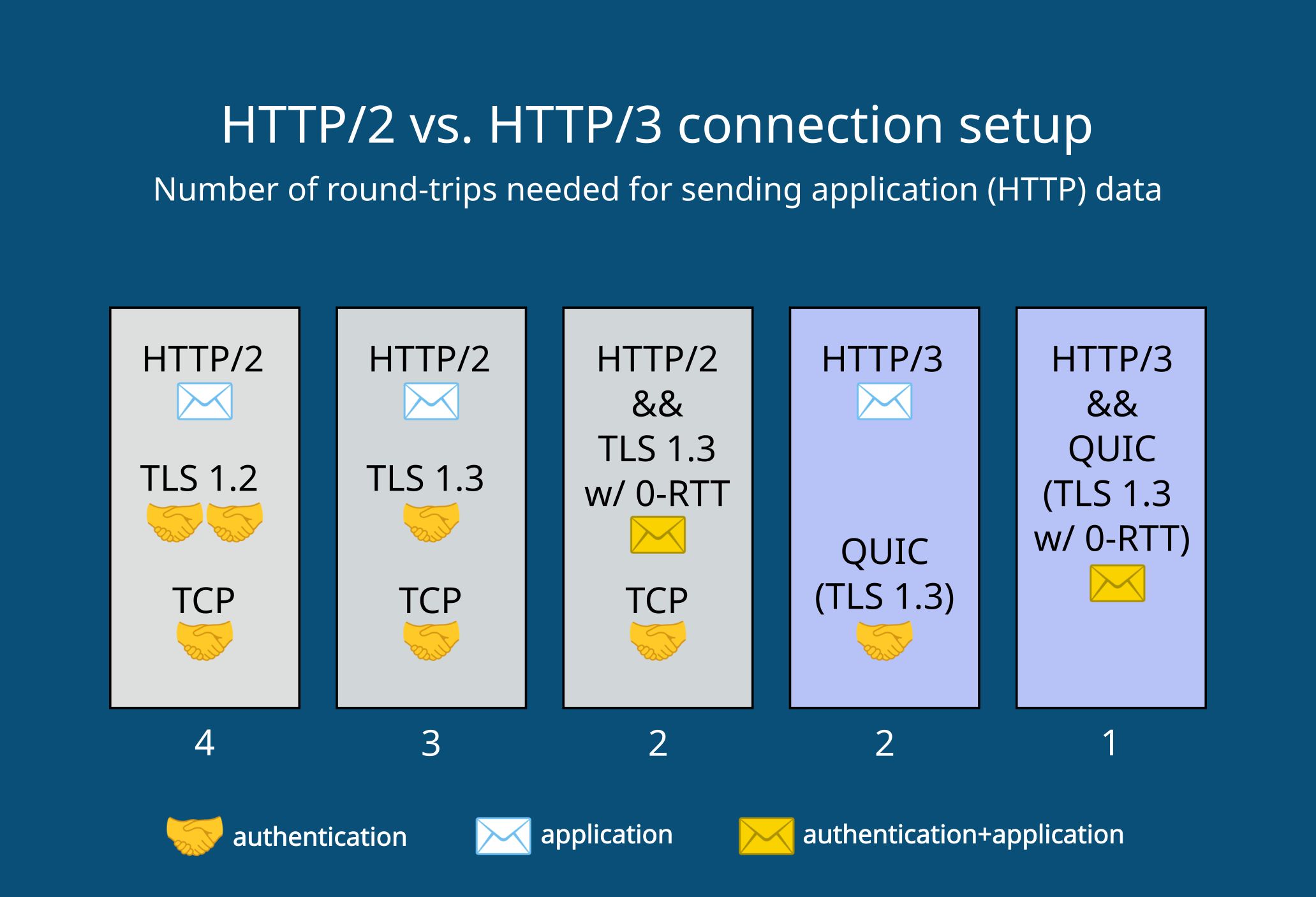

-- 当使用HTTP2和TLS 1.2时,client发送第一个http request需要4个round-trip

-- 在使用HTTP2和TLS 1.3时,client发送第一个http equest需要2、3个round-trip(根据是否使用0-rtt有所不同)

-- 在使用HTTP3和QUIC时,其默认包含TLS 1.3,其可以在1、2个round-trip内发送第一个http请求(根据是否复用先前连接的加密信息)

-

-### Head-of-Line Blocking Removal

-HTTP/3协议栈和HTTP/2协议栈的结构不同,其解决了HTTP/2中最大的性能问题:`head-of-line`阻塞。

-- 该问题主要发生在HTTP/2中packet丢失的场景下,直到丢失的包被重传前,整个的数据传输过程都会停止,所有packets都必须在网络上等待,这将会导致页面的加载时间延长

-

-在HTTP/3中,行首阻塞通过原生的多路复用解决了。这是QUIC最重要的特性之一。

-

-#### HOL blocking术语

-如下是HOL问题涉及到的概念:

-- byte stream:是通过网络发送的字节序列。bytes作为不同大小的packets被传输。byte stream本质上是单个资源(file)的物理表现形式,通过网络来发送

-- 复用:通过复用,可以在一个connection上传输多个byte streams,这将代表浏览器可以在同一个连接上同时加载多个文件

- - 在HTTP/1.1中,并不支持复用,其会未每个byte stream新开一个tcp连接。HTTP/2中引入了应用层的复用,其只会建立一个TCP连接,并通过其传输所有byte streams。故而,仅有HTTP/2会存在HOL问题

-- HOL blocking:这是由tcp byte stream抽象造成的性能问题。TCP并不知晓其所传输的数据,并将其所传输的所有数据都看作一个byte stream。故而,如果在网络传输过程中,任意位置的packet发生的丢失,所有在复用连接中的其他packets都会停止传输,并等待丢失的packets被重传

- - 这代表,复用的连接中,所有byte streams都会被TCP协议看作是一个byte stream,故而stream A中的packet丢失也会造成stream B的传输被阻塞,直至丢失packet被重传

- - 并且,TCP使用了in-order传输,如果发生packet丢失,那么将阻塞整个的传输过程。在高丢包率的环境下,这将极大程度上影响传输速度。即使在HTTP/2中已经引入了性能优化特性,在2%丢包率的场景下,也会比HTTP/1.1的传输速度更慢

-- native multiplexing:在HTTP/3协议栈中,复用被移动到了传输层,实现了原生复用。QUIC通过stream ID来表示每个byte stream,并不像TCP一样将所有byte streams都看作是一个。

-

-#### How does QUIC remove head-of-line blocking

-QUIC基于UDP实现,其使用了out-of-order delivery,故而每个byte stream都通过网络独立的进行传输。然而,为了可靠性,QUIC确保了在同一byte stream内packets的in-order delivery,故而相同请求中关联的数据到达的顺序是一致的。

-

-QUIC标识了所有byte stream,并且streams是独立进行传输的,如果发生packet丢失,其他byte streams并不会停止并等待重传。

-

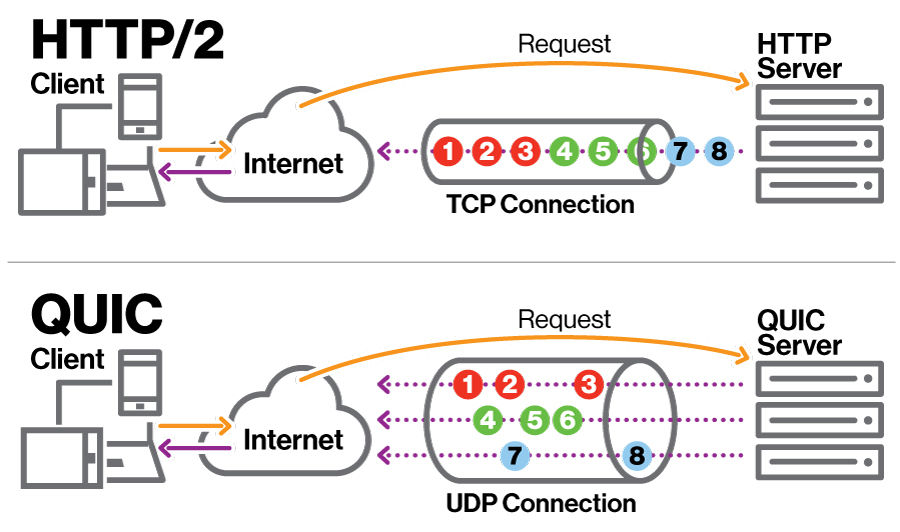

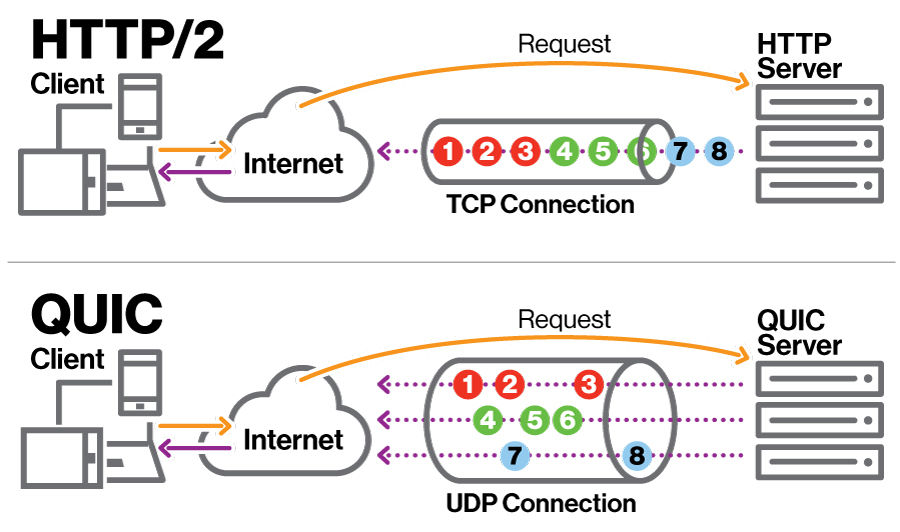

-下图中展示了QUIC原生复用和HTTP2应用层复用的区别:

-

-

-- 当使用HTTP2和TLS 1.2时,client发送第一个http request需要4个round-trip

-- 在使用HTTP2和TLS 1.3时,client发送第一个http equest需要2、3个round-trip(根据是否使用0-rtt有所不同)

-- 在使用HTTP3和QUIC时,其默认包含TLS 1.3,其可以在1、2个round-trip内发送第一个http请求(根据是否复用先前连接的加密信息)

-

-### Head-of-Line Blocking Removal

-HTTP/3协议栈和HTTP/2协议栈的结构不同,其解决了HTTP/2中最大的性能问题:`head-of-line`阻塞。

-- 该问题主要发生在HTTP/2中packet丢失的场景下,直到丢失的包被重传前,整个的数据传输过程都会停止,所有packets都必须在网络上等待,这将会导致页面的加载时间延长

-

-在HTTP/3中,行首阻塞通过原生的多路复用解决了。这是QUIC最重要的特性之一。

-

-#### HOL blocking术语

-如下是HOL问题涉及到的概念:

-- byte stream:是通过网络发送的字节序列。bytes作为不同大小的packets被传输。byte stream本质上是单个资源(file)的物理表现形式,通过网络来发送

-- 复用:通过复用,可以在一个connection上传输多个byte streams,这将代表浏览器可以在同一个连接上同时加载多个文件

- - 在HTTP/1.1中,并不支持复用,其会未每个byte stream新开一个tcp连接。HTTP/2中引入了应用层的复用,其只会建立一个TCP连接,并通过其传输所有byte streams。故而,仅有HTTP/2会存在HOL问题

-- HOL blocking:这是由tcp byte stream抽象造成的性能问题。TCP并不知晓其所传输的数据,并将其所传输的所有数据都看作一个byte stream。故而,如果在网络传输过程中,任意位置的packet发生的丢失,所有在复用连接中的其他packets都会停止传输,并等待丢失的packets被重传

- - 这代表,复用的连接中,所有byte streams都会被TCP协议看作是一个byte stream,故而stream A中的packet丢失也会造成stream B的传输被阻塞,直至丢失packet被重传

- - 并且,TCP使用了in-order传输,如果发生packet丢失,那么将阻塞整个的传输过程。在高丢包率的环境下,这将极大程度上影响传输速度。即使在HTTP/2中已经引入了性能优化特性,在2%丢包率的场景下,也会比HTTP/1.1的传输速度更慢

-- native multiplexing:在HTTP/3协议栈中,复用被移动到了传输层,实现了原生复用。QUIC通过stream ID来表示每个byte stream,并不像TCP一样将所有byte streams都看作是一个。

-

-#### How does QUIC remove head-of-line blocking

-QUIC基于UDP实现,其使用了out-of-order delivery,故而每个byte stream都通过网络独立的进行传输。然而,为了可靠性,QUIC确保了在同一byte stream内packets的in-order delivery,故而相同请求中关联的数据到达的顺序是一致的。

-

-QUIC标识了所有byte stream,并且streams是独立进行传输的,如果发生packet丢失,其他byte streams并不会停止并等待重传。

-

-下图中展示了QUIC原生复用和HTTP2应用层复用的区别:

- -

-如上图所示,HTTP/2和HTTP/3在传输多个资源时,都只创建了一个连接。但是,QUIC中不同byte streams是独立传输的,拥有不同的传输路径,并且不同byte streams之间不会彼此阻塞。

-

-即使QUIC解决了HTTP/2中引入的HOL问题,乱序传输也会存在弊端:byte streams并不会按照其被发送的顺序到达。例如,在使用乱序传输时,最不重要的资源可能会最先到达。

-

-#### Flexible Bandwidth Management

-带宽管理用于在packets和streams之间按照最优的方式对网络带宽进行分配。这是至关重要的功能,发送方和接收方的机器以及二者之间的网络节点处理packets的速度都有所不同,并且速度也会动态变化。

-

-带宽管理有助于避免网络中的数据溢出和拥塞,这些问题可能会导致server响应速度变慢,同时也可能会带来安全问题。

-

-UDP中并没有内置带宽控制,QUIC则是在HTTP3协议栈中负责该功能,其对TCP带宽管理中的两大部分进行了重新实现:

-- 流控制: 其在接收方限制了数据发送的速率,用于避免发送方造成接收方过载

-- 拥塞控制:其限制了发送方和接收方之间的路径中每一个节点的发送速率,用于避免网络拥塞

-

-##### Pre-Stream Flow Control

-为了支持独立的stream,QUIC采用了per-stream based flow control。其在两个级别控制了stream data的带宽消耗:

-- 对于每个独立的流,都设置了一个可分配给其的最大数据数量

-- 在整个连接范的围内,设置了active streams最大的累积数量

-

-通过per-stream flow control,QUIC限制了同时可以发送的数据数量,用于避免接收方过载,并且在多个streams间大致公平的分配网络容量。

-

-##### 拥塞控制算法

-QUIC允许实现选择不同的拥塞控制算法,使用最广泛的算法如下:

-- NewReno:TCP使用的拥塞控制算法

-- CUBIC: 和NewReno类似,但是使用了cubic function而不是linear function

-- BBR

-

-在网络状况较差的场景下,不同的拥塞控制算法性能可能存在较大差异。

-

+- [HTTP3 \& QUIC Protocols](#http3--quic-protocols)

+ - [What is HTTP3](#what-is-http3)

+ - [TCP/IP模型中HTTP3 vs QUIC](#tcpip模型中http3-vs-quic)

+ - [QUIC Protocol](#quic-protocol)

+ - [What is QUIC Used For](#what-is-quic-used-for)

+ - [HTTP/1.1 vs HTTP/2 vs HTTP/3: Main differences](#http11-vs-http2-vs-http3-main-differences)

+ - [Best Features of HTTP/3 and QUIC](#best-features-of-http3-and-quic)

+ - [QUIC handshake](#quic-handshake)

+ - [0-RTT on Prior Connections](#0-rtt-on-prior-connections)

+ - [Head-of-Line Blocking Removal](#head-of-line-blocking-removal)

+ - [HOL blocking术语](#hol-blocking术语)

+ - [How does QUIC remove head-of-line blocking](#how-does-quic-remove-head-of-line-blocking)

+ - [Flexible Bandwidth Management](#flexible-bandwidth-management)

+ - [Pre-Stream Flow Control](#pre-stream-flow-control)

+ - [拥塞控制算法](#拥塞控制算法)

+

+

+# HTTP3 & QUIC Protocols

+http3旨在通过QUIC(下一代传输层协议)来令网站更快、更安全。

+

+在协议高层,http3提供了和http2相同的功能,例如header compression和stream优先级控制。然而,在协议底层,QUIC传输层协议彻底修改了web传输数据的方式。

+

+## What is HTTP3

+HTTP是一个应用层的网络传输协议,定义了client和server之间的request-reponse机制,允许client/server发送和接收HTML文档和其他文本、meidia files。

+

+http3最初被称为`HTTP-over-QUIC`,其主要目标是令http语法及现存的http/2功能能够和QUIC传输协议兼容。

+

+故而,`HTTP/3`的所有新特性都来源于QUIC层,包括内置加密、新型加密握手、对先前的连接进行zero round-trip恢复,消除头部阻塞问题以及原生多路复用。

+

+## TCP/IP模型中HTTP3 vs QUIC

+通过internet传输信息是复杂的操作,涉及到软件和硬件层面。由于不同的设备、工具、软件都拥有不同的特性,故而单一协议无法描述完整的通信流程。

+

+故而,网络通信是已于通信的协议栈实现的,协议栈中每一层职责都不同。为了使用网络系统来通信,host必须实现构成互联网协议套件的一系列分层协议集。通常,主机至少为每层实现一个协议。

+

+而HTTP则是应用层协议,令web server和web browser之间可以相互通信。http消息(request/reponse)在互联网中则是通过传输层协议来进行传递:

+- 在http/2和http/1.1中,通过TCP协议来进行传递

+- 在`http/3`中,则是通过QUIC协议来进行传递

+

+> `QUIC`为http/3新基于的传输层协议,之前http都基于tcp协议进行传输

+

+## QUIC Protocol

+`QUIC`协议是一个通用的传输层协议,其可以和任意兼容的应用层协议来一起使用,HTTP/3是QUIC的最新用例。

+

+`QUIC`协议基于`UDP`协议构建,其负责server和client之间应用数据的物理传输。UDP协议是一个简单、轻量的协议,其传输速度高但是缺失可靠性、安全性等特性。QUIC实现了这些高层的传输特性,故而可以用于优化http数据通过网络的传输。

+

+在HTTP/3中,HTTP的连接从`TCP-based`迁移到了`UDP-based`,底层的网络通信结构都发生了变化。

+

+### What is QUIC Used For

+QUIC其创建是同于代替`TCP`协议的,QUIC作为传输层协议,相比于TCP更加灵活,性能问题更少。QUIC协议继承了安全传输的特性,并且拥有更快的adoption rate。

+

+QUIC协议底层基于UDP协议的原因是`大多数设备只支持TCP和UDP的端口号`。

+

+除此之外,`QUIC`还利用了UDP的如下特性:

+- UDP的connectionless特性可以使其将多路复用下移到传输层,并且基于UDP的QUIC实现并不会和TCP协议一样存在头部阻塞的问题

+- UDP的间接性能够令QUIC重新实现TCP的可靠性和带宽管理功能

+

+基于QUIC协议的传输和TCP相比是完全不同的方案:

+- 在底层,其是无连接的,其底层基于UDP协议

+- 在高层,其是`connection-oriented`的,其在高层重新实现了TCP协议中连接建立、loss detection等特性,从而确保了数据的可靠传输

+

+综上,QUIC协议结合了UDP和TCP两种协议的优点。

+

+除了上述优点外,QUIC还`在传输层实现了高级别的安全性`。QUIC集成了`TLS 1.3`协议中的大部分特性,令其和自身的传输机制相兼容。在`HTTP/3` stack中,encryption并非是可选的,而是内置特性。

+

+TCP, UDP, QUIC协议的相互比较如下:

+| | TCP | UDP | QUIC |

+| :-: | :-: | :-: | :-: |

+Layer in the TCP/IP model | transport | transport | transport |

+| place in the TCP/IP model | on top of ipv4/ipv6 | on top of ipv4/ipv6 | on top of UDP |

+| connection type | connection-oriented | connectionless | connection-oriented |

+| order of delivery | in-order delivery | out-of-order delivery | out-of-order delivery between streams, in order delivery within stremas |

+| guarantee of delivery | guaranteed | no guarantee of delivery | guaranteed |

+| security | unencrypted | unencrypted | encrypted |

+| data identification | knows nothing about the data it transports | knows nothing about the data it transports | use stream IDs to identify the independent streams it transports |

+

+## HTTP/1.1 vs HTTP/2 vs HTTP/3: Main differences

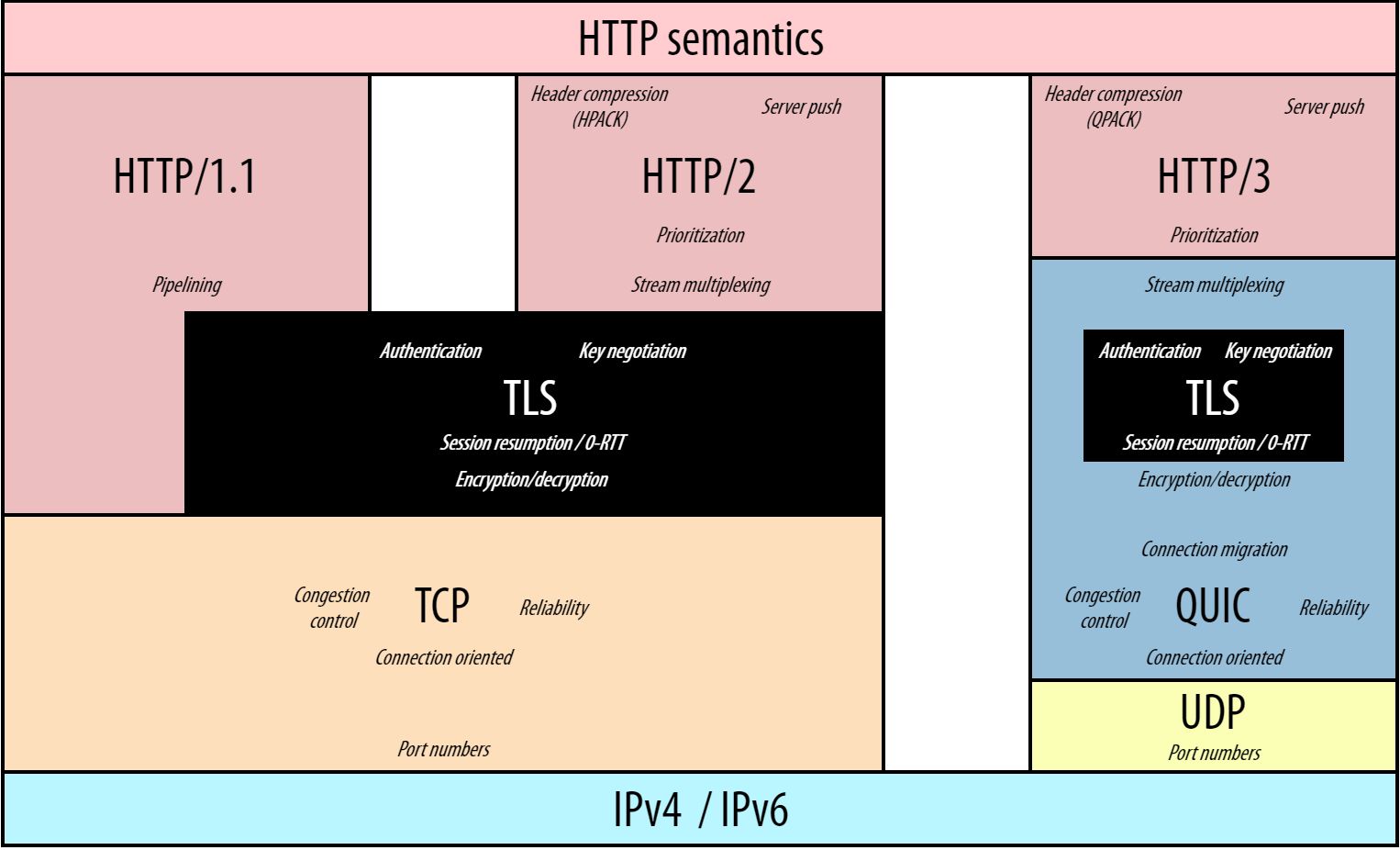

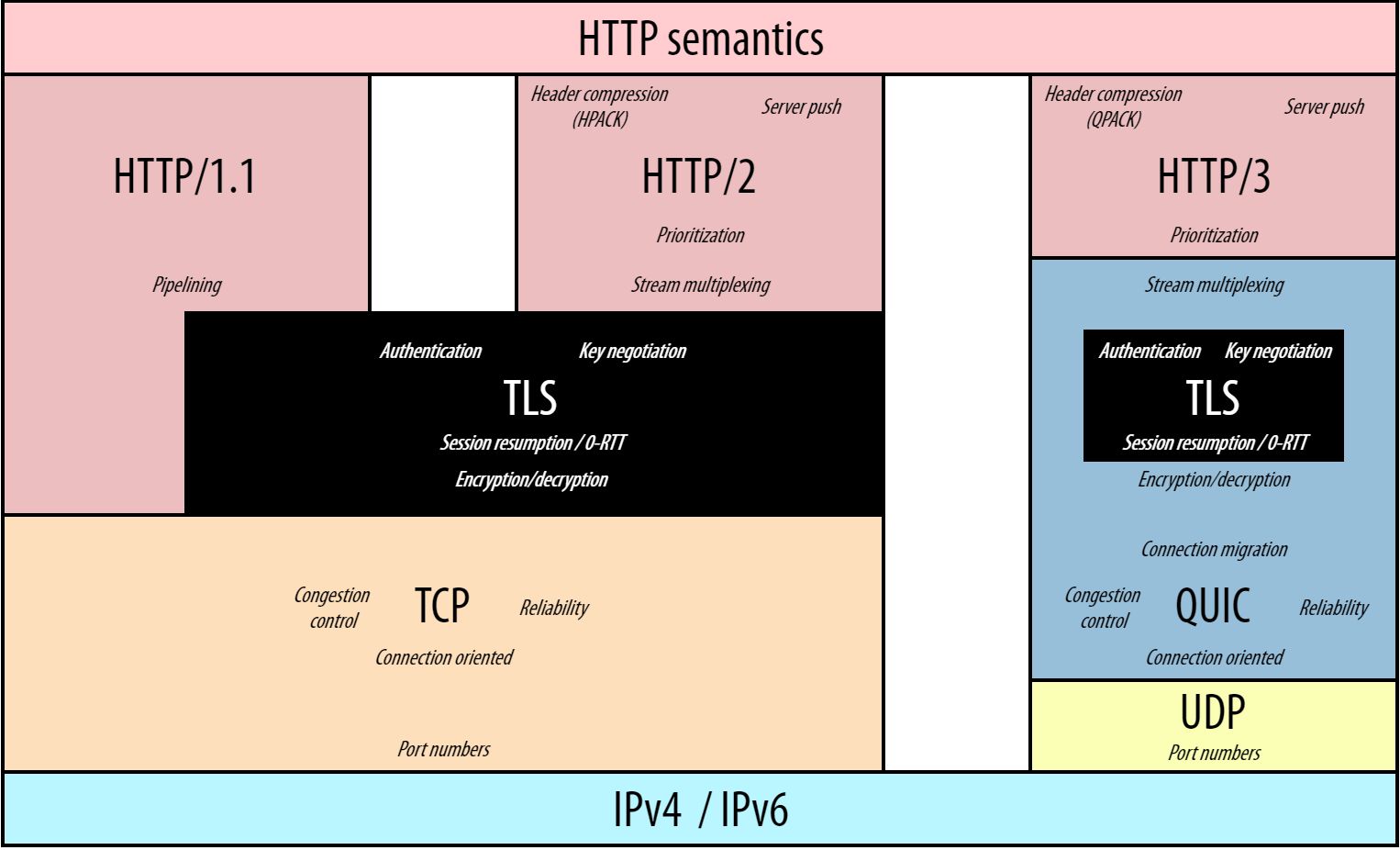

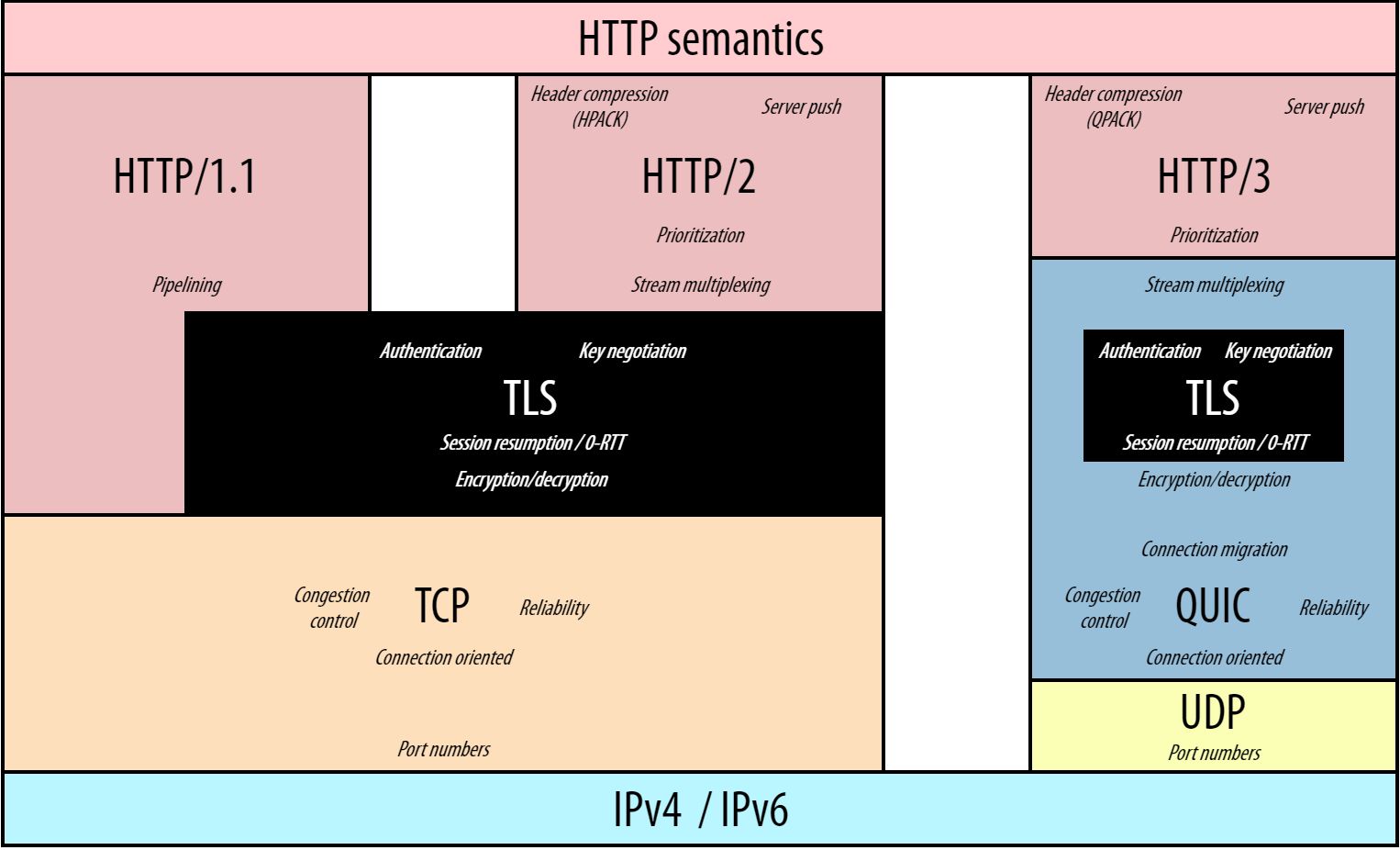

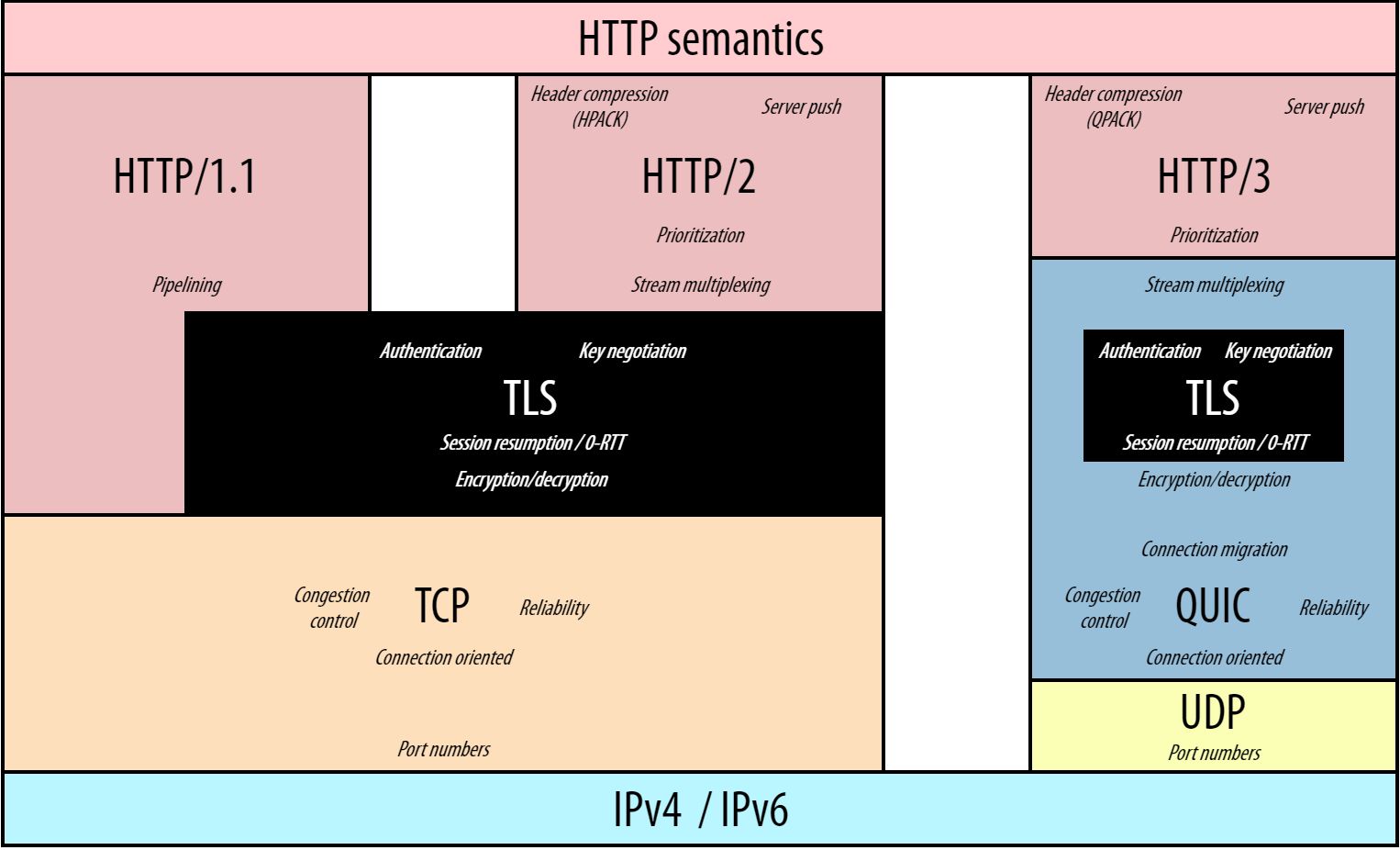

+H3除了在底层协议栈传输层中引入QUIC和UDP协议外,还存在其他改动,具体如图所示:

+

-

-如上图所示,HTTP/2和HTTP/3在传输多个资源时,都只创建了一个连接。但是,QUIC中不同byte streams是独立传输的,拥有不同的传输路径,并且不同byte streams之间不会彼此阻塞。

-

-即使QUIC解决了HTTP/2中引入的HOL问题,乱序传输也会存在弊端:byte streams并不会按照其被发送的顺序到达。例如,在使用乱序传输时,最不重要的资源可能会最先到达。

-

-#### Flexible Bandwidth Management

-带宽管理用于在packets和streams之间按照最优的方式对网络带宽进行分配。这是至关重要的功能,发送方和接收方的机器以及二者之间的网络节点处理packets的速度都有所不同,并且速度也会动态变化。

-

-带宽管理有助于避免网络中的数据溢出和拥塞,这些问题可能会导致server响应速度变慢,同时也可能会带来安全问题。

-

-UDP中并没有内置带宽控制,QUIC则是在HTTP3协议栈中负责该功能,其对TCP带宽管理中的两大部分进行了重新实现:

-- 流控制: 其在接收方限制了数据发送的速率,用于避免发送方造成接收方过载

-- 拥塞控制:其限制了发送方和接收方之间的路径中每一个节点的发送速率,用于避免网络拥塞

-

-##### Pre-Stream Flow Control

-为了支持独立的stream,QUIC采用了per-stream based flow control。其在两个级别控制了stream data的带宽消耗:

-- 对于每个独立的流,都设置了一个可分配给其的最大数据数量

-- 在整个连接范的围内,设置了active streams最大的累积数量

-

-通过per-stream flow control,QUIC限制了同时可以发送的数据数量,用于避免接收方过载,并且在多个streams间大致公平的分配网络容量。

-

-##### 拥塞控制算法

-QUIC允许实现选择不同的拥塞控制算法,使用最广泛的算法如下:

-- NewReno:TCP使用的拥塞控制算法

-- CUBIC: 和NewReno类似,但是使用了cubic function而不是linear function

-- BBR

-

-在网络状况较差的场景下,不同的拥塞控制算法性能可能存在较大差异。

-

+- [HTTP3 \& QUIC Protocols](#http3--quic-protocols)

+ - [What is HTTP3](#what-is-http3)

+ - [TCP/IP模型中HTTP3 vs QUIC](#tcpip模型中http3-vs-quic)

+ - [QUIC Protocol](#quic-protocol)

+ - [What is QUIC Used For](#what-is-quic-used-for)

+ - [HTTP/1.1 vs HTTP/2 vs HTTP/3: Main differences](#http11-vs-http2-vs-http3-main-differences)

+ - [Best Features of HTTP/3 and QUIC](#best-features-of-http3-and-quic)

+ - [QUIC handshake](#quic-handshake)

+ - [0-RTT on Prior Connections](#0-rtt-on-prior-connections)

+ - [Head-of-Line Blocking Removal](#head-of-line-blocking-removal)

+ - [HOL blocking术语](#hol-blocking术语)

+ - [How does QUIC remove head-of-line blocking](#how-does-quic-remove-head-of-line-blocking)

+ - [Flexible Bandwidth Management](#flexible-bandwidth-management)

+ - [Pre-Stream Flow Control](#pre-stream-flow-control)

+ - [拥塞控制算法](#拥塞控制算法)

+

+

+# HTTP3 & QUIC Protocols

+http3旨在通过QUIC(下一代传输层协议)来令网站更快、更安全。

+

+在协议高层,http3提供了和http2相同的功能,例如header compression和stream优先级控制。然而,在协议底层,QUIC传输层协议彻底修改了web传输数据的方式。

+

+## What is HTTP3

+HTTP是一个应用层的网络传输协议,定义了client和server之间的request-reponse机制,允许client/server发送和接收HTML文档和其他文本、meidia files。

+

+http3最初被称为`HTTP-over-QUIC`,其主要目标是令http语法及现存的http/2功能能够和QUIC传输协议兼容。

+

+故而,`HTTP/3`的所有新特性都来源于QUIC层,包括内置加密、新型加密握手、对先前的连接进行zero round-trip恢复,消除头部阻塞问题以及原生多路复用。

+

+## TCP/IP模型中HTTP3 vs QUIC

+通过internet传输信息是复杂的操作,涉及到软件和硬件层面。由于不同的设备、工具、软件都拥有不同的特性,故而单一协议无法描述完整的通信流程。

+

+故而,网络通信是已于通信的协议栈实现的,协议栈中每一层职责都不同。为了使用网络系统来通信,host必须实现构成互联网协议套件的一系列分层协议集。通常,主机至少为每层实现一个协议。

+

+而HTTP则是应用层协议,令web server和web browser之间可以相互通信。http消息(request/reponse)在互联网中则是通过传输层协议来进行传递:

+- 在http/2和http/1.1中,通过TCP协议来进行传递

+- 在`http/3`中,则是通过QUIC协议来进行传递

+

+> `QUIC`为http/3新基于的传输层协议,之前http都基于tcp协议进行传输

+

+## QUIC Protocol

+`QUIC`协议是一个通用的传输层协议,其可以和任意兼容的应用层协议来一起使用,HTTP/3是QUIC的最新用例。

+

+`QUIC`协议基于`UDP`协议构建,其负责server和client之间应用数据的物理传输。UDP协议是一个简单、轻量的协议,其传输速度高但是缺失可靠性、安全性等特性。QUIC实现了这些高层的传输特性,故而可以用于优化http数据通过网络的传输。

+

+在HTTP/3中,HTTP的连接从`TCP-based`迁移到了`UDP-based`,底层的网络通信结构都发生了变化。

+

+### What is QUIC Used For

+QUIC其创建是同于代替`TCP`协议的,QUIC作为传输层协议,相比于TCP更加灵活,性能问题更少。QUIC协议继承了安全传输的特性,并且拥有更快的adoption rate。

+

+QUIC协议底层基于UDP协议的原因是`大多数设备只支持TCP和UDP的端口号`。

+

+除此之外,`QUIC`还利用了UDP的如下特性:

+- UDP的connectionless特性可以使其将多路复用下移到传输层,并且基于UDP的QUIC实现并不会和TCP协议一样存在头部阻塞的问题

+- UDP的间接性能够令QUIC重新实现TCP的可靠性和带宽管理功能

+

+基于QUIC协议的传输和TCP相比是完全不同的方案:

+- 在底层,其是无连接的,其底层基于UDP协议

+- 在高层,其是`connection-oriented`的,其在高层重新实现了TCP协议中连接建立、loss detection等特性,从而确保了数据的可靠传输

+

+综上,QUIC协议结合了UDP和TCP两种协议的优点。

+

+除了上述优点外,QUIC还`在传输层实现了高级别的安全性`。QUIC集成了`TLS 1.3`协议中的大部分特性,令其和自身的传输机制相兼容。在`HTTP/3` stack中,encryption并非是可选的,而是内置特性。

+

+TCP, UDP, QUIC协议的相互比较如下:

+| | TCP | UDP | QUIC |

+| :-: | :-: | :-: | :-: |

+Layer in the TCP/IP model | transport | transport | transport |

+| place in the TCP/IP model | on top of ipv4/ipv6 | on top of ipv4/ipv6 | on top of UDP |

+| connection type | connection-oriented | connectionless | connection-oriented |

+| order of delivery | in-order delivery | out-of-order delivery | out-of-order delivery between streams, in order delivery within stremas |

+| guarantee of delivery | guaranteed | no guarantee of delivery | guaranteed |

+| security | unencrypted | unencrypted | encrypted |

+| data identification | knows nothing about the data it transports | knows nothing about the data it transports | use stream IDs to identify the independent streams it transports |

+

+## HTTP/1.1 vs HTTP/2 vs HTTP/3: Main differences

+H3除了在底层协议栈传输层中引入QUIC和UDP协议外,还存在其他改动,具体如图所示:

+ +

+HTTP/3-QUIC-UDP stack和TCP-based版本的HTTP最重要的区别如下:

+- QUIC集成了TLS 1.3协议中绝大部分特性,encryption从应用层移动到了传输层

+- HTTP/3在不同的streams间并不会对连接进行多路复用,多路复用的特性是由QUIC在传输层执行的

+ - 传输层的多路复用移解决了HTTP/2中TCP中头部阻塞的问题(HTTP/1.1中并不存在头部阻塞问题,因为其会开启多个TCP连接,并且会提供pipelining选项,后来该方案被发现拥有严重实现缺陷,被替换为了HTTP/2中应用层的多路复用)

+

+## Best Features of HTTP/3 and QUIC

+HTTP/3和QUIC的新特性能够令server connections速度更快、传输更安全、可靠性更高。

+

+### QUIC handshake

+在HTTP2中,client和server在执行handshake的过程中,至少需要2次round-trips:

+- tcp handshake需要一次round-trip

+- tls handleshake至少需要一次round-trip

+

+和QUIC则将上述两次handshakes整合成了一个,HTTP3仅需一次round-trip就可以在client和server之间建立一个secure connection。`QUIC可以带来更快的连接建立和更低的延迟。`

+

+QUIC集成了`TLS1.3`中的绝大多数特性,`TLS1.3`是目前最新版本的`Transport Layer Security`协议,其代表:

+- HTTP/3中,消息的加密是强制的,并不像HTTP/1.1和HTTP/2中一样是可选的。在使用HTTP/3时,所有的消息都默认通过encrypted connection来进行发送。

+- TLS 1.3引入了一个`improved cryptographic handshake`,在client和server间仅需要一次round-trip;而TLS 1.2中则需要两次round-trips用于认证

+ - 而在QUIC中,则将该`improved cryptographic handshake`和其本身用于连接创建的handshake进行了整合,并替代了TCP的handshake

+- 在HTTP/3中,消息都是在传输层加密的,故而加密的信息比HTTP/1.1和HTTP/2中都更多

+ - 在HTTP/1.1和HTTP/2协议栈中,TLS都运行在应用层,故而HTTP data是加密的,但是,TCP header则是明文发送的,TCP header的明文可能会带来一些安全问题

+ - 在HTTP/3 stack中,TLS运行在传输层,故而不仅http message被加密,大多数QUIC packet header也是被加密的

+

+简单来说,HTTP/3使用的传输机制相比于TCP-based HTTP版本来说要更加安全。(传输层协议本身的header也被加密)

+

+### 0-RTT on Prior Connections

+对于先前存在的connections,QUIC利用了TLS 1.3的`0-RTT`特性。

+

+`0-RTT`代表zero round-trip time resumption,是TLS 1.3中引入的一个新特性。

+

+TLS session resumption通过复用先前建立的安全参数,减少建立secure connection所花费的时间。当client和server频繁建立连接并断开时,这将带来性能改善。

+

+通过0-RTT resumption,client可以在连接的第一个round-trip中发送http请求,复用先前建立的cryptographic keys。

+

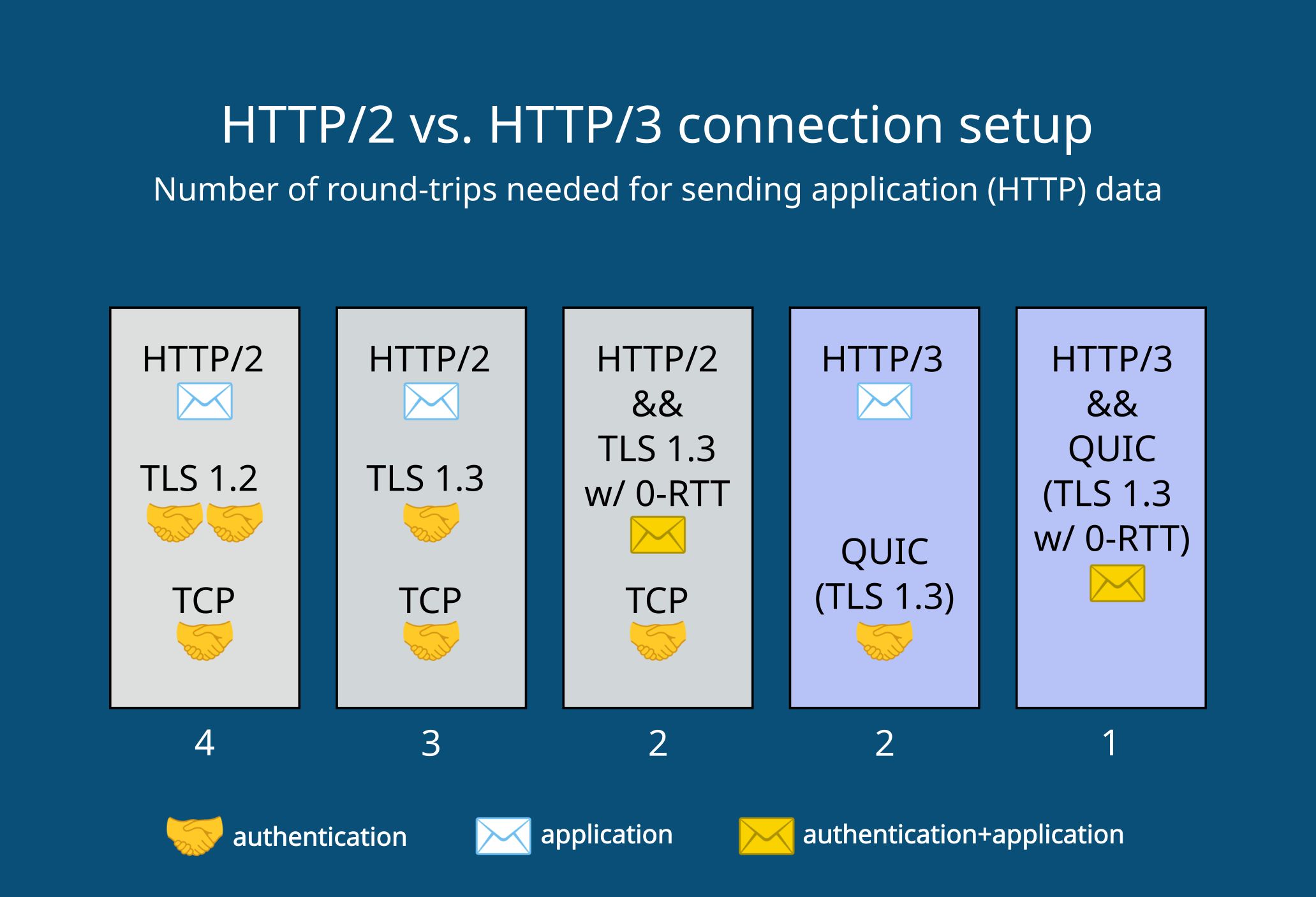

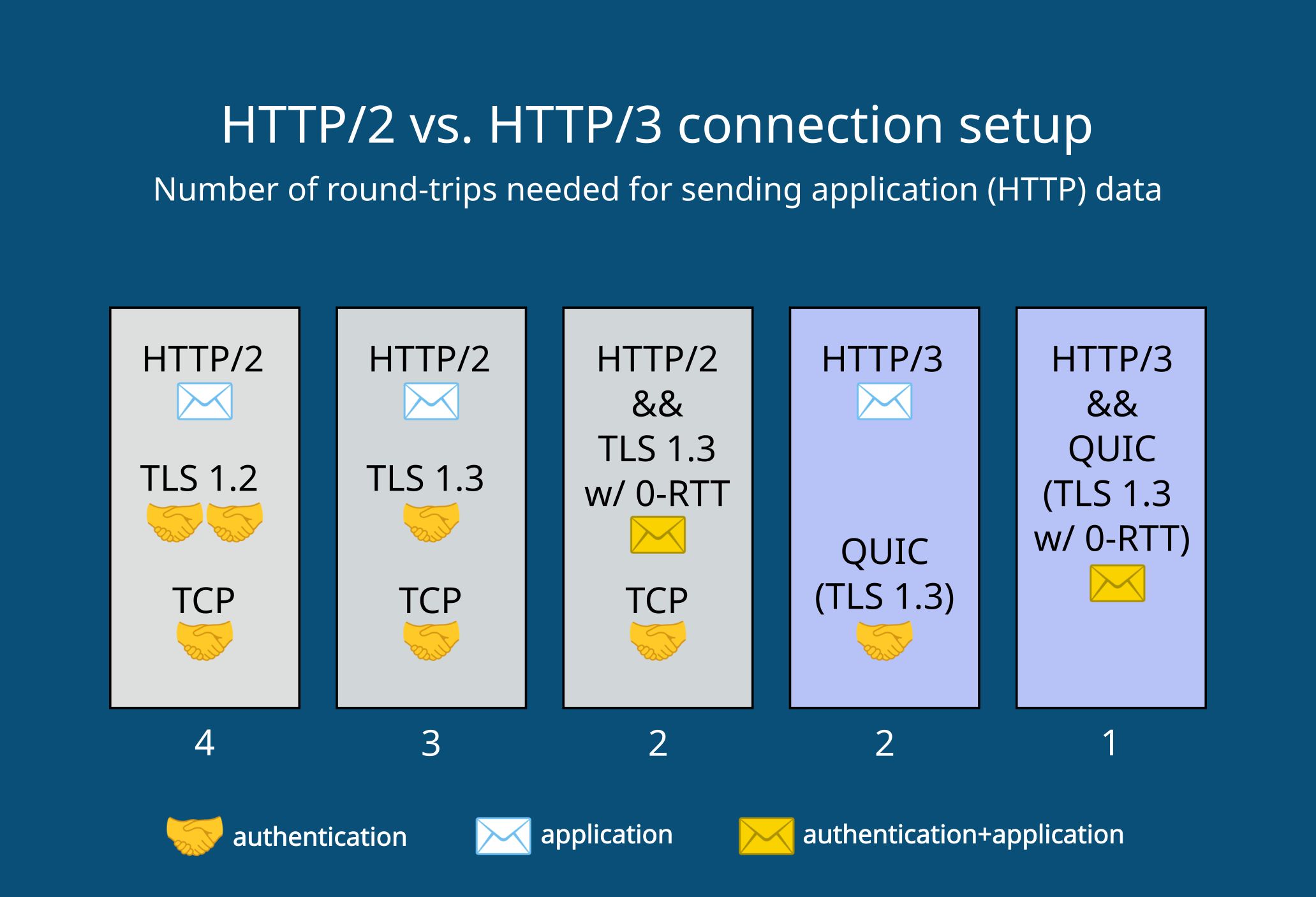

+下面展示了H2和H3 stack在建立连接时的区别:

+

+

+

+HTTP/3-QUIC-UDP stack和TCP-based版本的HTTP最重要的区别如下:

+- QUIC集成了TLS 1.3协议中绝大部分特性,encryption从应用层移动到了传输层

+- HTTP/3在不同的streams间并不会对连接进行多路复用,多路复用的特性是由QUIC在传输层执行的

+ - 传输层的多路复用移解决了HTTP/2中TCP中头部阻塞的问题(HTTP/1.1中并不存在头部阻塞问题,因为其会开启多个TCP连接,并且会提供pipelining选项,后来该方案被发现拥有严重实现缺陷,被替换为了HTTP/2中应用层的多路复用)

+

+## Best Features of HTTP/3 and QUIC

+HTTP/3和QUIC的新特性能够令server connections速度更快、传输更安全、可靠性更高。

+

+### QUIC handshake

+在HTTP2中,client和server在执行handshake的过程中,至少需要2次round-trips:

+- tcp handshake需要一次round-trip

+- tls handleshake至少需要一次round-trip

+

+和QUIC则将上述两次handshakes整合成了一个,HTTP3仅需一次round-trip就可以在client和server之间建立一个secure connection。`QUIC可以带来更快的连接建立和更低的延迟。`

+

+QUIC集成了`TLS1.3`中的绝大多数特性,`TLS1.3`是目前最新版本的`Transport Layer Security`协议,其代表:

+- HTTP/3中,消息的加密是强制的,并不像HTTP/1.1和HTTP/2中一样是可选的。在使用HTTP/3时,所有的消息都默认通过encrypted connection来进行发送。

+- TLS 1.3引入了一个`improved cryptographic handshake`,在client和server间仅需要一次round-trip;而TLS 1.2中则需要两次round-trips用于认证

+ - 而在QUIC中,则将该`improved cryptographic handshake`和其本身用于连接创建的handshake进行了整合,并替代了TCP的handshake

+- 在HTTP/3中,消息都是在传输层加密的,故而加密的信息比HTTP/1.1和HTTP/2中都更多

+ - 在HTTP/1.1和HTTP/2协议栈中,TLS都运行在应用层,故而HTTP data是加密的,但是,TCP header则是明文发送的,TCP header的明文可能会带来一些安全问题

+ - 在HTTP/3 stack中,TLS运行在传输层,故而不仅http message被加密,大多数QUIC packet header也是被加密的

+

+简单来说,HTTP/3使用的传输机制相比于TCP-based HTTP版本来说要更加安全。(传输层协议本身的header也被加密)

+

+### 0-RTT on Prior Connections

+对于先前存在的connections,QUIC利用了TLS 1.3的`0-RTT`特性。

+

+`0-RTT`代表zero round-trip time resumption,是TLS 1.3中引入的一个新特性。

+

+TLS session resumption通过复用先前建立的安全参数,减少建立secure connection所花费的时间。当client和server频繁建立连接并断开时,这将带来性能改善。

+

+通过0-RTT resumption,client可以在连接的第一个round-trip中发送http请求,复用先前建立的cryptographic keys。

+

+下面展示了H2和H3 stack在建立连接时的区别:

+

+ +

+- 当使用HTTP2和TLS 1.2时,client发送第一个http request需要4个round-trip

+- 在使用HTTP2和TLS 1.3时,client发送第一个http equest需要2、3个round-trip(根据是否使用0-rtt有所不同)

+- 在使用HTTP3和QUIC时,其默认包含TLS 1.3,其可以在1、2个round-trip内发送第一个http请求(根据是否复用先前连接的加密信息)

+

+### Head-of-Line Blocking Removal

+HTTP/3协议栈和HTTP/2协议栈的结构不同,其解决了HTTP/2中最大的性能问题:`head-of-line`阻塞。

+- 该问题主要发生在HTTP/2中packet丢失的场景下,直到丢失的包被重传前,整个的数据传输过程都会停止,所有packets都必须在网络上等待,这将会导致页面的加载时间延长

+

+在HTTP/3中,行首阻塞通过原生的多路复用解决了。这是QUIC最重要的特性之一。

+

+#### HOL blocking术语

+如下是HOL问题涉及到的概念:

+- byte stream:是通过网络发送的字节序列。bytes作为不同大小的packets被传输。byte stream本质上是单个资源(file)的物理表现形式,通过网络来发送

+- 复用:通过复用,可以在一个connection上传输多个byte streams,这将代表浏览器可以在同一个连接上同时加载多个文件

+ - 在HTTP/1.1中,并不支持复用,其会未每个byte stream新开一个tcp连接。HTTP/2中引入了应用层的复用,其只会建立一个TCP连接,并通过其传输所有byte streams。故而,仅有HTTP/2会存在HOL问题

+- HOL blocking:这是由tcp byte stream抽象造成的性能问题。TCP并不知晓其所传输的数据,并将其所传输的所有数据都看作一个byte stream。故而,如果在网络传输过程中,任意位置的packet发生的丢失,所有在复用连接中的其他packets都会停止传输,并等待丢失的packets被重传

+ - 这代表,复用的连接中,所有byte streams都会被TCP协议看作是一个byte stream,故而stream A中的packet丢失也会造成stream B的传输被阻塞,直至丢失packet被重传

+ - 并且,TCP使用了in-order传输,如果发生packet丢失,那么将阻塞整个的传输过程。在高丢包率的环境下,这将极大程度上影响传输速度。即使在HTTP/2中已经引入了性能优化特性,在2%丢包率的场景下,也会比HTTP/1.1的传输速度更慢

+- native multiplexing:在HTTP/3协议栈中,复用被移动到了传输层,实现了原生复用。QUIC通过stream ID来表示每个byte stream,并不像TCP一样将所有byte streams都看作是一个。

+

+#### How does QUIC remove head-of-line blocking

+QUIC基于UDP实现,其使用了out-of-order delivery,故而每个byte stream都通过网络独立的进行传输。然而,为了可靠性,QUIC确保了在同一byte stream内packets的in-order delivery,故而相同请求中关联的数据到达的顺序是一致的。

+

+QUIC标识了所有byte stream,并且streams是独立进行传输的,如果发生packet丢失,其他byte streams并不会停止并等待重传。

+

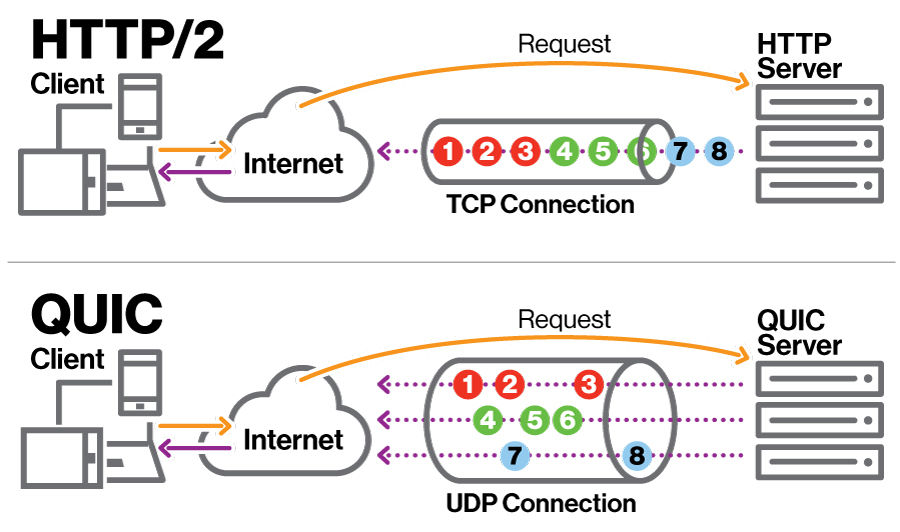

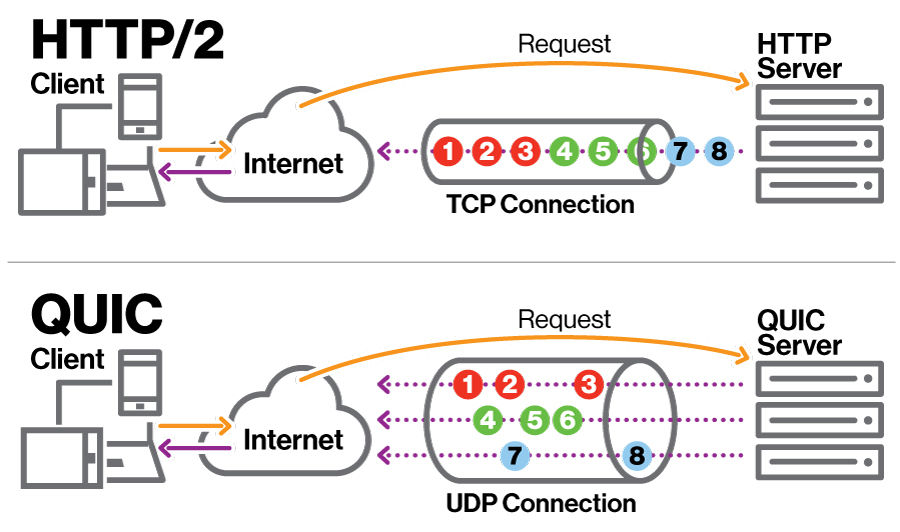

+下图中展示了QUIC原生复用和HTTP2应用层复用的区别:

+

+

+- 当使用HTTP2和TLS 1.2时,client发送第一个http request需要4个round-trip

+- 在使用HTTP2和TLS 1.3时,client发送第一个http equest需要2、3个round-trip(根据是否使用0-rtt有所不同)

+- 在使用HTTP3和QUIC时,其默认包含TLS 1.3,其可以在1、2个round-trip内发送第一个http请求(根据是否复用先前连接的加密信息)

+

+### Head-of-Line Blocking Removal

+HTTP/3协议栈和HTTP/2协议栈的结构不同,其解决了HTTP/2中最大的性能问题:`head-of-line`阻塞。

+- 该问题主要发生在HTTP/2中packet丢失的场景下,直到丢失的包被重传前,整个的数据传输过程都会停止,所有packets都必须在网络上等待,这将会导致页面的加载时间延长

+

+在HTTP/3中,行首阻塞通过原生的多路复用解决了。这是QUIC最重要的特性之一。

+

+#### HOL blocking术语

+如下是HOL问题涉及到的概念:

+- byte stream:是通过网络发送的字节序列。bytes作为不同大小的packets被传输。byte stream本质上是单个资源(file)的物理表现形式,通过网络来发送

+- 复用:通过复用,可以在一个connection上传输多个byte streams,这将代表浏览器可以在同一个连接上同时加载多个文件

+ - 在HTTP/1.1中,并不支持复用,其会未每个byte stream新开一个tcp连接。HTTP/2中引入了应用层的复用,其只会建立一个TCP连接,并通过其传输所有byte streams。故而,仅有HTTP/2会存在HOL问题

+- HOL blocking:这是由tcp byte stream抽象造成的性能问题。TCP并不知晓其所传输的数据,并将其所传输的所有数据都看作一个byte stream。故而,如果在网络传输过程中,任意位置的packet发生的丢失,所有在复用连接中的其他packets都会停止传输,并等待丢失的packets被重传

+ - 这代表,复用的连接中,所有byte streams都会被TCP协议看作是一个byte stream,故而stream A中的packet丢失也会造成stream B的传输被阻塞,直至丢失packet被重传

+ - 并且,TCP使用了in-order传输,如果发生packet丢失,那么将阻塞整个的传输过程。在高丢包率的环境下,这将极大程度上影响传输速度。即使在HTTP/2中已经引入了性能优化特性,在2%丢包率的场景下,也会比HTTP/1.1的传输速度更慢

+- native multiplexing:在HTTP/3协议栈中,复用被移动到了传输层,实现了原生复用。QUIC通过stream ID来表示每个byte stream,并不像TCP一样将所有byte streams都看作是一个。

+

+#### How does QUIC remove head-of-line blocking

+QUIC基于UDP实现,其使用了out-of-order delivery,故而每个byte stream都通过网络独立的进行传输。然而,为了可靠性,QUIC确保了在同一byte stream内packets的in-order delivery,故而相同请求中关联的数据到达的顺序是一致的。

+

+QUIC标识了所有byte stream,并且streams是独立进行传输的,如果发生packet丢失,其他byte streams并不会停止并等待重传。

+

+下图中展示了QUIC原生复用和HTTP2应用层复用的区别:

+ +

+如上图所示,HTTP/2和HTTP/3在传输多个资源时,都只创建了一个连接。但是,QUIC中不同byte streams是独立传输的,拥有不同的传输路径,并且不同byte streams之间不会彼此阻塞。

+

+即使QUIC解决了HTTP/2中引入的HOL问题,乱序传输也会存在弊端:byte streams并不会按照其被发送的顺序到达。例如,在使用乱序传输时,最不重要的资源可能会最先到达。

+

+#### Flexible Bandwidth Management

+带宽管理用于在packets和streams之间按照最优的方式对网络带宽进行分配。这是至关重要的功能,发送方和接收方的机器以及二者之间的网络节点处理packets的速度都有所不同,并且速度也会动态变化。

+

+带宽管理有助于避免网络中的数据溢出和拥塞,这些问题可能会导致server响应速度变慢,同时也可能会带来安全问题。

+

+UDP中并没有内置带宽控制,QUIC则是在HTTP3协议栈中负责该功能,其对TCP带宽管理中的两大部分进行了重新实现:

+- 流控制: 其在接收方限制了数据发送的速率,用于避免发送方造成接收方过载

+- 拥塞控制:其限制了发送方和接收方之间的路径中每一个节点的发送速率,用于避免网络拥塞

+

+##### Pre-Stream Flow Control

+为了支持独立的stream,QUIC采用了per-stream based flow control。其在两个级别控制了stream data的带宽消耗:

+- 对于每个独立的流,都设置了一个可分配给其的最大数据数量

+- 在整个连接范的围内,设置了active streams最大的累积数量

+

+通过per-stream flow control,QUIC限制了同时可以发送的数据数量,用于避免接收方过载,并且在多个streams间大致公平的分配网络容量。

+

+##### 拥塞控制算法

+QUIC允许实现选择不同的拥塞控制算法,使用最广泛的算法如下:

+- NewReno:TCP使用的拥塞控制算法

+- CUBIC: 和NewReno类似,但是使用了cubic function而不是linear function

+- BBR

+

+在网络状况较差的场景下,不同的拥塞控制算法性能可能存在较大差异。

+

diff --git a/java se/垃圾回收和引用.md b/java se/垃圾回收和引用.md

index 70c62c9..dd9b2a9 100644

--- a/java se/垃圾回收和引用.md

+++ b/java se/垃圾回收和引用.md

@@ -1,109 +1,109 @@

-- [垃圾回收和引用](#垃圾回收和引用)

- - [finalize](#finalize)

- - [引用](#引用)

- - [Reference](#reference)

- - [get](#get)

- - [clear](#clear)

- - [enqueue](#enqueue)

- - [isEnqueue](#isenqueue)

- - [引用的可达性](#引用的可达性)

- - [强可达(strongly reachable)](#强可达strongly-reachable)

- - [软可达(softly reachable)](#软可达softly-reachable)

- - [弱可达(weakly reachable)](#弱可达weakly-reachable)

- - [终结器可达(finalizer reachable)](#终结器可达finalizer-reachable)

- - [幽灵可达(phantom reachable)](#幽灵可达phantom-reachable)

- - [引用类型](#引用类型)

- - [软引用(SoftReference)](#软引用softreference)

- - [弱引用(WeakReference)](#弱引用weakreference)

- - [幽灵可达](#幽灵可达)

- - [Weak Hash Map](#weak-hash-map)

- - [引用队列](#引用队列)

- - [ReferenceQueue.poll](#referencequeuepoll)

- - [ReferenceQueue.remove](#referencequeueremove)

- - [弱引用和软引用的使用](#弱引用和软引用的使用)

-

-# 垃圾回收和引用

-## finalize

-finalize方法将会在对象的空间被回收之前被调用。如果一个对象被垃圾回收器判为不可达而需要被回收时,垃圾回收器将调用该对象的finalize方法,通过finalize方法可以清除对象的一些非内存资源。

-在每个对象中,finalize方法最多被调用一次。

-> finalize方法可以抛出任何异常,但是抛出的异常将被垃圾回收器忽略。

-

-在finalize方法调用时,该对象引用的其他对象可能也是垃圾对象,并且已经被回收。

-## 引用

-### Reference

-Reference是一个抽象类,是所有特定引用类的父类。

-#### get

-```java

-public Object get()

-```

-将会返回引用对象指向的被引用对象

-#### clear

-```java

-public void clear()

-```

-清空引用对象从而使其不指向任何对象

-#### enqueue

-```java

-public boolean enqueue()

-```

-如果存在引用对象,将引用对象加入到注册的引用队列中,如果加入队列成功,返回true;如果没有成功加入到队列,或者该引用对象已经在队列中,那么返回false

-#### isEnqueue

-```java

-public boolean isEnqueue()

-```

-如果该引用对象已经被加入到引用队列中,那么返回true,否则返回false

-### 引用的可达性

-#### 强可达(strongly reachable)

-至少通过一条强引用链可达

-#### 软可达(softly reachable)

-不是强可达,但是至少可以通过一条包含软引用的引用链可达

-#### 弱可达(weakly reachable)

-不是弱可达,但是至少通过一条包含弱引用的引用链可达

-#### 终结器可达(finalizer reachable)

-不是弱可达,但是该对象的finalize方法尚未执行

-#### 幽灵可达(phantom reachable)

-如果finalize方法已经执行,但是可通过至少一条包含幽灵引用的引用链可达

-### 引用类型

-#### 软引用(SoftReference)

-对于软可达的对象,垃圾回收程序会随意进行处置,如果可用内存很低,回收器会清空SoftReference对象中的引用,之后该被引用对象则能被回收

-> 在抛出OOM之前,所有的SoftReference引用将会被清空

-

-#### 弱引用(WeakReference)

-弱可达对象将会被垃圾回收器回收,如果垃圾回收器认为对象是弱可达的,所有指向其的WeakReference对象都会被清空

-

-#### 幽灵可达

-幽灵可达并不是真正的可达,虚引用并不会影响对象的生命周期,如果一个对象和虚引用关联,则该对象跟没有与该虚引用关联一样,在任何时候都有可能被垃圾回收。虚引用主要用于跟踪对象垃圾回收的活动。

-

-### Weak Hash Map

-WeakHashMap会使用WeakReference来存储key。

-如果垃圾回收器发现一个对象弱可达时,会将弱引用放入到引用队列中。WeakHashMap会定期检查引用队列中新到达的弱引用,并且新到的弱引用代表该key不再被使用,WeakHashMap会移除关联的entry。

-

-

-### 引用队列

-如果对象的可达性状态发生了改变,那么执行该对象的引用类型将会被放置到引用队列中。引用队列通常被垃圾回收器使用。

-也可以在自己的代码中对引用队列进行使用,通过引用队列,可以监听对象的可达性改变。

-> 例如当对象不再被强引用,变为弱可达时,引用将会被添加到引用队列中,再通过代码监听引用队列的变化,即可监听到对象可达性的变化

-

-> ReferenceQueue是线程安全的。

-

-#### ReferenceQueue.poll

-```java

-pulbic Reference poll()

-```

-该方法会删除并且返回队列中的下一个引用对象,若队列为空,则返回值为null

-

-#### ReferenceQueue.remove

-```java

-public Reference remove() throws InterruptedException

-```

-该方法同样会删除并返回队列中下一个引用对象,但是该方法在队列为空时会无限阻塞下去

-```java

-public Reference remove(long timeout) throws InterruptedException

-```

-

-引用对象在构造时,会和特定的引用队列相关联,当被引用对象的可达性状态发生变化时,被添加到引用队列中。在被添加到队列之前,引用对象都已经被清空。

-

-### 弱引用和软引用的使用

-弱引用和软引用都提供两种类型的构造函数,

-- 只接受被引用对象,并不将引用注册到引用队列

+- [垃圾回收和引用](#垃圾回收和引用)

+ - [finalize](#finalize)

+ - [引用](#引用)

+ - [Reference](#reference)

+ - [get](#get)

+ - [clear](#clear)

+ - [enqueue](#enqueue)

+ - [isEnqueue](#isenqueue)

+ - [引用的可达性](#引用的可达性)

+ - [强可达(strongly reachable)](#强可达strongly-reachable)

+ - [软可达(softly reachable)](#软可达softly-reachable)

+ - [弱可达(weakly reachable)](#弱可达weakly-reachable)

+ - [终结器可达(finalizer reachable)](#终结器可达finalizer-reachable)

+ - [幽灵可达(phantom reachable)](#幽灵可达phantom-reachable)

+ - [引用类型](#引用类型)

+ - [软引用(SoftReference)](#软引用softreference)

+ - [弱引用(WeakReference)](#弱引用weakreference)

+ - [幽灵可达](#幽灵可达)

+ - [Weak Hash Map](#weak-hash-map)

+ - [引用队列](#引用队列)

+ - [ReferenceQueue.poll](#referencequeuepoll)

+ - [ReferenceQueue.remove](#referencequeueremove)

+ - [弱引用和软引用的使用](#弱引用和软引用的使用)

+

+# 垃圾回收和引用

+## finalize

+finalize方法将会在对象的空间被回收之前被调用。如果一个对象被垃圾回收器判为不可达而需要被回收时,垃圾回收器将调用该对象的finalize方法,通过finalize方法可以清除对象的一些非内存资源。

+在每个对象中,finalize方法最多被调用一次。

+> finalize方法可以抛出任何异常,但是抛出的异常将被垃圾回收器忽略。

+

+在finalize方法调用时,该对象引用的其他对象可能也是垃圾对象,并且已经被回收。

+## 引用

+### Reference

+Reference是一个抽象类,是所有特定引用类的父类。

+#### get

+```java

+public Object get()

+```

+将会返回引用对象指向的被引用对象

+#### clear

+```java

+public void clear()

+```

+清空引用对象从而使其不指向任何对象

+#### enqueue

+```java

+public boolean enqueue()

+```

+如果存在引用对象,将引用对象加入到注册的引用队列中,如果加入队列成功,返回true;如果没有成功加入到队列,或者该引用对象已经在队列中,那么返回false

+#### isEnqueue

+```java

+public boolean isEnqueue()

+```

+如果该引用对象已经被加入到引用队列中,那么返回true,否则返回false

+### 引用的可达性

+#### 强可达(strongly reachable)

+至少通过一条强引用链可达

+#### 软可达(softly reachable)

+不是强可达,但是至少可以通过一条包含软引用的引用链可达

+#### 弱可达(weakly reachable)

+不是弱可达,但是至少通过一条包含弱引用的引用链可达

+#### 终结器可达(finalizer reachable)

+不是弱可达,但是该对象的finalize方法尚未执行

+#### 幽灵可达(phantom reachable)

+如果finalize方法已经执行,但是可通过至少一条包含幽灵引用的引用链可达

+### 引用类型

+#### 软引用(SoftReference)

+对于软可达的对象,垃圾回收程序会随意进行处置,如果可用内存很低,回收器会清空SoftReference对象中的引用,之后该被引用对象则能被回收

+> 在抛出OOM之前,所有的SoftReference引用将会被清空

+

+#### 弱引用(WeakReference)

+弱可达对象将会被垃圾回收器回收,如果垃圾回收器认为对象是弱可达的,所有指向其的WeakReference对象都会被清空

+

+#### 幽灵可达

+幽灵可达并不是真正的可达,虚引用并不会影响对象的生命周期,如果一个对象和虚引用关联,则该对象跟没有与该虚引用关联一样,在任何时候都有可能被垃圾回收。虚引用主要用于跟踪对象垃圾回收的活动。

+

+### Weak Hash Map

+WeakHashMap会使用WeakReference来存储key。

+如果垃圾回收器发现一个对象弱可达时,会将弱引用放入到引用队列中。WeakHashMap会定期检查引用队列中新到达的弱引用,并且新到的弱引用代表该key不再被使用,WeakHashMap会移除关联的entry。

+

+

+### 引用队列

+如果对象的可达性状态发生了改变,那么执行该对象的引用类型将会被放置到引用队列中。引用队列通常被垃圾回收器使用。

+也可以在自己的代码中对引用队列进行使用,通过引用队列,可以监听对象的可达性改变。

+> 例如当对象不再被强引用,变为弱可达时,引用将会被添加到引用队列中,再通过代码监听引用队列的变化,即可监听到对象可达性的变化

+

+> ReferenceQueue是线程安全的。

+

+#### ReferenceQueue.poll

+```java

+pulbic Reference poll()

+```

+该方法会删除并且返回队列中的下一个引用对象,若队列为空,则返回值为null

+

+#### ReferenceQueue.remove

+```java

+public Reference remove() throws InterruptedException

+```

+该方法同样会删除并返回队列中下一个引用对象,但是该方法在队列为空时会无限阻塞下去

+```java

+public Reference remove(long timeout) throws InterruptedException

+```

+

+引用对象在构造时,会和特定的引用队列相关联,当被引用对象的可达性状态发生变化时,被添加到引用队列中。在被添加到队列之前,引用对象都已经被清空。

+

+### 弱引用和软引用的使用

+弱引用和软引用都提供两种类型的构造函数,

+- 只接受被引用对象,并不将引用注册到引用队列

- 既接受被引用对象,还将引用注册到指定的引用队列,然后可以通过检查引用队列中的情况来监听被引用对象可达状态变更

\ No newline at end of file

diff --git a/mysql/mysql文档/mysql_文件.md b/mysql/mysql文档/mysql_文件.md

index 043490e..d7b5d3d 100644

--- a/mysql/mysql文档/mysql_文件.md

+++ b/mysql/mysql文档/mysql_文件.md

@@ -1,363 +1,363 @@

-- [文件](#文件)

- - [参数](#参数)

- - [参数查看](#参数查看)

- - [参数类型](#参数类型)

- - [动态参数修改](#动态参数修改)

- - [静态参数修改](#静态参数修改)

- - [日志文件](#日志文件)

- - [错误日志](#错误日志)

- - [慢查询日志](#慢查询日志)

- - [log\_queries\_not\_using\_indexes](#log_queries_not_using_indexes)

- - [查询日志](#查询日志)

- - [二进制日志](#二进制日志)

- - [max\_binlog\_size](#max_binlog_size)

- - [binlog\_cache\_size](#binlog_cache_size)

- - [binlog\_cache\_use](#binlog_cache_use)

- - [binlog\_cache\_disk\_use](#binlog_cache_disk_use)

- - [sync\_binlog](#sync_binlog)

- - [innodb\_flush\_log\_at\_trx\_commit](#innodb_flush_log_at_trx_commit)

- - [binlog\_format](#binlog_format)

- - [使用statement可能会存在的问题](#使用statement可能会存在的问题)

- - [mysqlbinlog](#mysqlbinlog)

- - [pid文件](#pid文件)

- - [表结构定义文件](#表结构定义文件)

- - [表空间文件](#表空间文件)

- - [innodb\_data\_file\_path](#innodb_data_file_path)

- - [innodb\_file\_per\_table](#innodb_file_per_table)

- - [redo log文件](#redo-log文件)

- - [循环写入](#循环写入)

- - [redo log capacity](#redo-log-capacity)

- - [redo log和binlog的区别](#redo-log和binlog的区别)

- - [记录内容](#记录内容)

- - [写入时机](#写入时机)

- - [redo log写入时机](#redo-log写入时机)

-

-

-# 文件

-## 参数

-### 参数查看

-mysql参数为键值对,可以通过`show variables`命令查看所有的数据库参数,并可以通过`like`来过滤参数名称。

-

-除了`show variables`命令之外,还能够在`performance_schema`下的`global_variables`视图来查找数据库参数,示例如下:

-```sql

--- 查看innodb_buffer_pool_size参数

-show variables like 'innodb_buffer_pool_size'

-```

-上述`show variables`命令的执行结果为

-| Variable\_name | Value |

-| :--- | :--- |

-| innodb\_buffer\_pool\_size | 4294967296 |

-

-```sql

-select * from performance_schema.global_variables where variable_name like 'innodb_buffer_pool%';

-```

-上述sql的执行结果如下:

-| VARIABLE\_NAME | VARIABLE\_VALUE |

-| :--- | :--- |

-| innodb\_buffer\_pool\_chunk\_size | 134217728 |

-| innodb\_buffer\_pool\_dump\_at\_shutdown | ON |

-| innodb\_buffer\_pool\_dump\_now | OFF |

-| innodb\_buffer\_pool\_dump\_pct | 25 |

-| innodb\_buffer\_pool\_filename | ib\_buffer\_pool |

-| innodb\_buffer\_pool\_in\_core\_file | ON |

-| innodb\_buffer\_pool\_instances | 4 |

-| innodb\_buffer\_pool\_load\_abort | OFF |

-| innodb\_buffer\_pool\_load\_at\_startup | ON |

-| innodb\_buffer\_pool\_load\_now | OFF |

-| innodb\_buffer\_pool\_size | 4294967296 |

-

-### 参数类型

-mysql中的参数可以分为`动态`和`静态`两种类型,

-- 动态:动态参数代表可以在mysql运行过程中进行修改

-- 静态:代表在整个实例的声明周期内都不得进行修改

-

-#### 动态参数修改

-对于动态参数,可以在运行时通过`SET`命令来进行修改,`SET`命令语法如下:

-```sql

-set

- | [global | session] system_var_name=expr

- | [@@global. | @@session. | @@] system_var_name = expr

-```

-在上述语法中,`global`和`session`关键字代表该动态参数的修改是针对`当前会话`还是针对`整个实例的生命周期`。

-

-- 有些动态参数只能在会话范围内进行修改,例如`autocommit`

-- 有些参数修改后,实例整个生命周期内都会生效,例如`binglog_cache_size`

-- 有些参数既可以在会话范围内进行修改,又可以在实例声明周期范围内进行修改,例如`read_buffer_size`

-

-使用示例如下:

-

-查询read_buffer_size的global和session值

-```sql

--- 查询read_buffer_size的global和session值

-select @@session.read_buffer_size,@@global.read_buffer_size;

-```

-返回结果为

-

-| @@session.read\_buffer\_size | @@global.read\_buffer\_size |

-| :--- | :--- |

-| 131072 | 131072 |

-

-设置@@session.read_buffer_size为524288

-```sql

-set @@session.read_buffer_size = 1024 * 512;

-```

-设置后,再次查询read_buffer_size的global和session值,结果为

-| @@session.read\_buffer\_size | @@global.read\_buffer\_size |

-| :--- | :--- |

-| 524288 | 131072 |

-

-在调用set命令修改session read_buffer_size参数后,session参数发生变化,但是global参数仍然为旧的值。

-

-> `set session xxx`命令并不会对global参数的值造成影响,新会话的参数值仍然为修改前的值。

-

-之后,再对global read_buffer_size值进行修改,执行如下命令

-```sql

-set @@global.read_buffer_size = 496 * 1024;

-```

-执行该命令后,sesion和global参数值为

-| @@session.read\_buffer\_size | @@global.read\_buffer\_size |

-| :--- | :--- |

-| 524288 | 507904 |

-

-> `set global xxx`命令只会修改global参数值,对session参数值不会造成影响,新的session其`session参数值, global参数值`和修改后的global参数值保持一致

-

-> 即使针对参数的global值进行了修改,其影响范围是当前实例的整个生命周期,`但是,其并不会对参数文件中的参数值进行修改,故而下次启动mysql实例时,仍然会从参数文件中取值,新实例的值仍然是修改前的值`。

->

-> 如果想要修改下次启动实例的参数值,需要修改参数文件中该参数的值。(参数文件路径通常为`/etc/my.cnf`)

-

-#### 静态参数修改

-在运行时,如果尝试对静态参数进行修改,那么会发生错误,示例如下:

-```sql

-> set global datadir='/db/mysql'

-[2025-01-30 15:05:17] [HY000][1238] Variable 'datadir' is a read only variable

-```

-## 日志文件

-mysql中常见日志文件如下

-- 错误日志(error log)

-- 二进制日志(binlog)

-- 慢查询日志(slow query log)

-- 查询日志(log)

-

-### 错误日志

-错误日志针对mysql的启动、运行、关闭过程进行了记录,用户可以通过`show variables like 'log_error';`来获取错误日志的路径:

-```sql

-show variables like 'log_error';

-```

-其输出值如下:

-| Variable\_name | Value |

-| :--- | :--- |

-| log\_error | /var/log/mysql/mysqld.log |

-

-当mysql数据库无法正常启动时,应当首先查看错误日志。

-

-### 慢查询日志

-慢查询日志存在一个阈值,通过`long_query_time`参数来进行控制,该参数默认值为`10`,代表慢查询的限制为10s。

-

-通过`slow_query_log`参数,可以控制是否日志输出慢查询日志,默认为`OFF`,如果需要开启慢查询日志,需要将该值设置为`ON`。

-

-关于慢查询日志的输出地点,可以通过`log_output`参数来进行控制。该参数默认为`FILE`,支持`FILE, TABLE, NONE`。`log_output`支持制定多个值,多个值之间可以通过`,`分隔,当值中包含`NONE`时,以`NONE`优先。

-

-#### log_queries_not_using_indexes

-当`log_queryies_not_using_indexes`开启时,如果运行的sql语句没有使用索引,那么这条sql同样会被输出到慢查询日志。该参数默认关闭。

-

-`log_throttle_queries_not_using_idnexes`用于记录`每分钟允许记录到慢查询日志并且没有使用索引`的sql语句次数,该参数值默认为0,代表每分钟输出到慢查询日志中的数量没有限制。

-

-该参数主要用于防止大量没有使用索引的sql添加到慢查询日志中,造成慢查询日志大小快速增加。

-

-当慢查询日志中的内容越来越多时,可以通过mysql提供的工具`mysqldumpslow`命令,示例如下:

-```sql

-mysqldumpslow -s at -n 10 ${slow_query_log_path}

-```

-

-### 查询日志

-查询日志记录了对mysql数据库所有的请求信息,无论请求是否正确执行。

-

-查询日志通过`general_log`参数来进行控制,默认该参数值为`OFF`.

-

-### 二进制日志

-二进制日志(binary log)记录了针对mysql数据库执行的所有更改操作(不包含select以及show这类读操作)。

-

-对于update操作等,即使没有对数据库进行修改(affected rows为0),也会被写入到binary log中。

-

-二进制日志的主要用途如下:

-- 恢复(recovery):某些数据恢复需要二进制日志,例如在数据库全备份文件恢复后,用户可以通过二进制日志进行point-in-time的恢复

-- 复制(replication):通过将一台主机(master)的binlog同步到另一台主机(slave),并且在另一台主机上执行该binlog,可以令slave与master进行实时同步

-- 审计(audit):用户可以对binlog中的信息进行审计,判断是否存在对数据库进行的注入攻击

-

-通过参数`log_bin`可以控制是否启用二进制日志。

-

-binlog通常存放在`datadir`参数所指定的目录路径下。在该路径下,还存在`binlog.index`文件,该文件为binlog的索引文件,文件内容包含所有binlog的文件名称。

-

-#### max_binlog_size

-`max_binlog_size`参数控制单个binlog文件的最大大小,如果单个文件超过该值,会产生新的二进制文件,新binlog的后缀会+1,并且新文件的文件名会被记录到`.index`文件中。

-

-`max_binlog_size`的默认值大小为`1G`。

-

-#### binlog_cache_size

-当使用innodb存储引擎时,所有未提交事务的binlog会被记录到缓存中,等到事务提交后,会将缓存中的binlog写入到文件中。缓存大小通过`binlog_cache_size`决定,该值默认为`32768`,即`32KB`。

-

-`binlog_cache_size`是基于会话的,`在每个线程开启一个事务时,mysql会自动分配一个大小为binlog_cache_size大小的缓存,因而该值不能设置过大`。

-

-当一个事务的记录大于设定的`binlog_cache_size`时,mysql会将缓冲中的日志写入到一个临时文件中,故而,该值无法设置过小。

-

-通过`show global status like 'binlog_cache%`命令可以查看`binlog_cache_use`和`binlog_cache_disk_use`的状态,可以通过上述两个状态判断binlog cache大小是否合适。

-

-##### binlog_cache_use

-`binlog_cache_use`记录了使用缓冲写binlog的次数

-

-##### binlog_cache_disk_use

-`binlog_cache_disk_use`记录了使用临时文件写二进制日志的次数

-

-#### sync_binlog

-`sync_binlog`参数控制mysql server同步binlog到磁盘的频率,该值默认为`1`

-

-- 0: 如果参数值为0,代表mysql server禁用binary log同步到磁盘。mysql会依赖操作系统将binary log刷新到磁盘中,该设置性能最佳,但是遇到操作系统崩溃时,可能会出现mysql事务提交但是还没有同步到binary log的场景

-- 1: 如果参数值设置为1,代表在事务提交之前将binary log同步到磁盘中,该设置最安全,但是会增加disk write次数,对性能会带来负面影响。在操作系统崩溃的场景下,binlog中缺失的事务还只处于prepared状态,从而确保binlog中没有事务丢失

-- N:当参数值被设置为非`0,1`的值时,每当n个binlog commit groups被收集到后,同步binlog到磁盘。在这种情况下,可能会发生事务提交但是还没有被刷新到binlog中,`当n值越大时,性能会越好,但是也会增加数据丢失的风险`

-

-为了在使用innodb事务和replciation时获得最好的一致性和持久性,请使用如下设置:

-```cnf

-sync_binlog=1

-innodb_flush_log_at_trx_commit=1

-```

-

-#### innodb_flush_log_at_trx_commit

-innodb_flush_log_at_trx_commit用于控制redo log的刷新。

-

-该参数用于平衡`commit操作ACID的合规性`以及`更高性能`。通过修改该参数值,可以实现更佳的性能,但是在崩溃时可能会丢失事务:

-- 1: 1为该参数默认值,代表完全的ACID合规性,日志在每次事务提交后被写入并刷新到磁盘中

-- 0: 日志每秒被写入和刷新到磁盘中,如果事务没有被刷新,那么日志将会在崩溃中被丢失

-- 2: 每当事务提交后,日志将会被写入,并且每秒钟都会被刷新到磁盘中。如果事务没有被刷新,崩溃同样会造成日志的丢失

-

-如果当前数据库为slave角色,那么其不会把`从master同步的binlog`写入到自己的binlog中,如果要实现`master=>slave=>slave`的同步架构,必须设置`log_slave_updates`参数。

-

-#### binlog_format

-binlog_format用于控制二进制文件的格式,可能有如下取值:

-- statement: 二进制文件记录的是日志的逻辑sql语句

-- row:记录表的行更改情况,默认值为`row`

-- mixed: 如果参数被配置为mixed,mysql默认会采用`statement`格式进行记录,但是在特定场景能够下会使用`row`格式:

- - 使用了uuid, user, current_user,found_rows, row_count等不确定函数

- - 使用了insert delay语句

- - 使用了用户自定义函数

- - 使用了临时表

-

-##### 使用statement可能会存在的问题

-在使用statement格式时,可能会存在如下问题

-- master运行rand,uuid等不确定函数时,或使用触发器操作时,会导致主从服务器上的数据不一致

-- innodb的默认事务隔离级别为`repetable_read`,如果使用`read_commited`级别时,statement格式可能会导致丢失更新的情况,从而令master和slave的数据不一致

-

-binlog为动态参数,可以在数据库运行时进行修改,并且可以针对session和global进行修改。

-

-#### mysqlbinlog

-在查看二进制日志时,可以使用`mysqlbinlog`命令,示例如下

-```bash

-mysqlbinlog --start-position=203 ${binlog_path}

-```

-

-## pid文件

-mysql实例启动时,会将进程id写入到一个文件中,该文件被称为pid文件。

-

-pid文件路径通过`pid_file`参数来进行控制,fedora中默认路径为`/run/mysqld/mysqld.pid`。

-

-## 表结构定义文件

-mysql中数据的存储是根据表进行的,每个表都有与之对应的文件。无论表采用何种存储引擎,都会存在一个以`frm`为后缀的文件,该文件中保存了该表的表结构定义。

-

-> mysql 8中,schema对应目录下不再包含frm文件。

-

-## 表空间文件

-innodb采用将存储的数据按照表空间(tablespace)进行存放的设计。在默认配置下,将会有一个初始大小为10MB,名称为ibdata1的文件,该文件为默认的表空间文件。

-

-### innodb_data_file_path

-可以通过`innodb_data_file_path`参数对默认表空间文件进行设置,示例如下:

-```sql

-innodb_data_file_path=datafile_spec1[;datafile_spec2]...

-```

-用户可以通过多个文件组成一个表空间,示例如下:

-```sql

-innodb_data_file_path=/db/ibdata1:2000M;/dr2/db/ibdata2:2000M;autoextend

-```

-在上述配置中,表空间由`/db/ibdata1`和`/dr2/db/ibdata2`两个文件组成,如果两个文件位于不同的磁盘上,那么磁盘的负载将会被平均,数据库的整体性能将会被提高。

-

-同时,在上述示例中,为两个文件都指定了后续属性,含义如下:

-- ibdata1:文件大小为2000M

-- ibdata2:文件大小为2000M,并且当文件大小被用完后,文件会自动增长

-

-当`innodb_data_file_path`被设置后,所有基于innodb存储引擎的表,其数据都会记录到该共享表空间中。

-

-### innodb_file_per_table

-如果`innodb_file_per_table`被启用后(默认启用),则每个基于innodb存储引擎的表都可以有一个独立的表空间,独立表空间的命名规则为`表名+.ibd`。

-

-通过innodb_file_per_table,用户不需要将所有的数据都放置在默认的表空间中。

-

-> `innodb_file_per_table`所产生的独立表空间文件,其仅存储该表的数据、索引和插入缓冲BITMAP信息,其余信息仍然存放在默认的表空间中。

-

-## redo log文件

-redo log是一个基于磁盘的数据结构,用于在crash recovery过程中纠正由`未完成事务写入的错误数据`。

-

-> 在一般操作中,redo log对那些`会造成表数据发生改变的请求`进行encode操作,请求通常由sql statement或地级别api发起。

-

-redo log通常代表磁盘上的redo log file。写入重做日志文件的数据通常基于受影响的记录进行编码。在数据被写入到redo log file中时,LSN值也会不断增加。

-

-### 循环写入

-innodb会按顺序写入redo log文件,例如redo log file group中存在两个文件,innodb会先写文件1,文件1写满后会切换文件2,在文件2写满后,重新切换到文件1。

-

-### redo log capacity

-从mysql 8.0.30开始,`innodb_redo_log_capacity`参数用于控制redo log file占用磁盘空间的大小。该参数可以在实例启动时进行设置,也可以通过`set global`来进行设置。

-

-`innodb_redo_log_capacity`默认值为`104857600`,即`100M`。

-

-redo log文件默认位于`datadir`路径下的`#innodb_redo`目录下。innodb会尝试维护32个redo log file,每个redo log file文件大小都相同,为`1/32 * innodb_redo_log_capacity`。

-

-redo log file将会使用`#ib_redoN`的命名方式,`N`是redo log file number。

-

-innodb redo log file分为如下两种:

-- ordinary:正在被使用的redo log file

-- spare:等待被使用的redo log file

-

-> 相比于ordinary redo log file,spare redo log file的名称中还包含了`_tmp`后缀

-

-每个oridnary redo log file都关联了一个制定的LSN范围,可以通过查询`performance_schema.innodb_redo_log_files`表里获取LSN范围。

-

-示例如下:

-```sql

-select file_name, start_lsn, end_lsn from performance_schema.innodb_redo_log_files;

-```

-查询结果示例如下:

-| file\_name | start\_lsn | end\_lsn |

-| :--- | :--- | :--- |

-| ./#innodb\_redo/#ib\_redo6 | 19656704 | 22931456 |

-

-当执行checkpoint时,innodb会将checkpoint LSN存储在文件的header中,在recovery过程中,所有的redo log文件都将被检查,并且基于最大的LSN来执行恢复操作。

-

-常用的redo log状态如下

-```bash

- # resize operation status

- Innodb_redo_log_resize_status

- # 当前redo log capacity

- Innodb_redo_log_capacity_resized

- Innodb_redo_log_checkpoint_lsn

- Innodb_redo_log_current_lsn

- Innodb_redo_log_flushed_to_disk_lsn

- Innodb_redo_log_logical_size

- Innodb_redo_log_physical_size

- Innodb_redo_log_read_only

- Innodb_redo_log_uuid

-```

-> 重做日志大小设置时,如果设置大小过大,那么在执行恢复操作时,可能需要花费很长时间;如果重做日志文件大小设置过小,可能会导致事务的日志需要多次切换重做日志文件。

->

-> 此外,重做日志太小会频繁发生async checkpoint,导致性能抖动。重做日志存在一个capacity,代表了最后的checkpoint不能够超过这个阈值,如果超过必须将缓冲区中的部分脏页刷新到磁盘中,此时可能会造成用户线程的阻塞。

-

-### redo log和binlog的区别

-#### 记录内容

-binlog记录的是一个事务的具体操作内容,该日志为逻辑日志。

-

-而innodb redo log记录的是关于某个页的修改,为物理日志。

-

-#### 写入时机

-binlog仅当事务提交前才进行提交,即只会写磁盘一次。

-

-redo log则是在事务运行过程中,不断有重做日志被写入到redo log file中。

-

-### redo log写入时机

-- master thread会每秒将redo log从buffer中刷新到redo log ile中,不露内事务是否已经提交

+- [文件](#文件)

+ - [参数](#参数)

+ - [参数查看](#参数查看)

+ - [参数类型](#参数类型)

+ - [动态参数修改](#动态参数修改)

+ - [静态参数修改](#静态参数修改)

+ - [日志文件](#日志文件)

+ - [错误日志](#错误日志)

+ - [慢查询日志](#慢查询日志)

+ - [log\_queries\_not\_using\_indexes](#log_queries_not_using_indexes)

+ - [查询日志](#查询日志)

+ - [二进制日志](#二进制日志)

+ - [max\_binlog\_size](#max_binlog_size)

+ - [binlog\_cache\_size](#binlog_cache_size)

+ - [binlog\_cache\_use](#binlog_cache_use)

+ - [binlog\_cache\_disk\_use](#binlog_cache_disk_use)

+ - [sync\_binlog](#sync_binlog)

+ - [innodb\_flush\_log\_at\_trx\_commit](#innodb_flush_log_at_trx_commit)

+ - [binlog\_format](#binlog_format)

+ - [使用statement可能会存在的问题](#使用statement可能会存在的问题)

+ - [mysqlbinlog](#mysqlbinlog)

+ - [pid文件](#pid文件)

+ - [表结构定义文件](#表结构定义文件)

+ - [表空间文件](#表空间文件)

+ - [innodb\_data\_file\_path](#innodb_data_file_path)

+ - [innodb\_file\_per\_table](#innodb_file_per_table)

+ - [redo log文件](#redo-log文件)

+ - [循环写入](#循环写入)

+ - [redo log capacity](#redo-log-capacity)

+ - [redo log和binlog的区别](#redo-log和binlog的区别)

+ - [记录内容](#记录内容)

+ - [写入时机](#写入时机)

+ - [redo log写入时机](#redo-log写入时机)

+

+

+# 文件

+## 参数

+### 参数查看

+mysql参数为键值对,可以通过`show variables`命令查看所有的数据库参数,并可以通过`like`来过滤参数名称。

+

+除了`show variables`命令之外,还能够在`performance_schema`下的`global_variables`视图来查找数据库参数,示例如下:

+```sql

+-- 查看innodb_buffer_pool_size参数

+show variables like 'innodb_buffer_pool_size'

+```

+上述`show variables`命令的执行结果为

+| Variable\_name | Value |

+| :--- | :--- |

+| innodb\_buffer\_pool\_size | 4294967296 |

+

+```sql

+select * from performance_schema.global_variables where variable_name like 'innodb_buffer_pool%';

+```

+上述sql的执行结果如下:

+| VARIABLE\_NAME | VARIABLE\_VALUE |

+| :--- | :--- |

+| innodb\_buffer\_pool\_chunk\_size | 134217728 |

+| innodb\_buffer\_pool\_dump\_at\_shutdown | ON |

+| innodb\_buffer\_pool\_dump\_now | OFF |

+| innodb\_buffer\_pool\_dump\_pct | 25 |

+| innodb\_buffer\_pool\_filename | ib\_buffer\_pool |

+| innodb\_buffer\_pool\_in\_core\_file | ON |

+| innodb\_buffer\_pool\_instances | 4 |

+| innodb\_buffer\_pool\_load\_abort | OFF |

+| innodb\_buffer\_pool\_load\_at\_startup | ON |

+| innodb\_buffer\_pool\_load\_now | OFF |

+| innodb\_buffer\_pool\_size | 4294967296 |

+

+### 参数类型

+mysql中的参数可以分为`动态`和`静态`两种类型,

+- 动态:动态参数代表可以在mysql运行过程中进行修改

+- 静态:代表在整个实例的声明周期内都不得进行修改

+

+#### 动态参数修改

+对于动态参数,可以在运行时通过`SET`命令来进行修改,`SET`命令语法如下:

+```sql

+set

+ | [global | session] system_var_name=expr

+ | [@@global. | @@session. | @@] system_var_name = expr

+```

+在上述语法中,`global`和`session`关键字代表该动态参数的修改是针对`当前会话`还是针对`整个实例的生命周期`。

+

+- 有些动态参数只能在会话范围内进行修改,例如`autocommit`

+- 有些参数修改后,实例整个生命周期内都会生效,例如`binglog_cache_size`

+- 有些参数既可以在会话范围内进行修改,又可以在实例声明周期范围内进行修改,例如`read_buffer_size`

+

+使用示例如下:

+

+查询read_buffer_size的global和session值

+```sql

+-- 查询read_buffer_size的global和session值

+select @@session.read_buffer_size,@@global.read_buffer_size;

+```

+返回结果为

+

+| @@session.read\_buffer\_size | @@global.read\_buffer\_size |

+| :--- | :--- |

+| 131072 | 131072 |

+

+设置@@session.read_buffer_size为524288

+```sql

+set @@session.read_buffer_size = 1024 * 512;

+```

+设置后,再次查询read_buffer_size的global和session值,结果为

+| @@session.read\_buffer\_size | @@global.read\_buffer\_size |

+| :--- | :--- |

+| 524288 | 131072 |

+

+在调用set命令修改session read_buffer_size参数后,session参数发生变化,但是global参数仍然为旧的值。

+

+> `set session xxx`命令并不会对global参数的值造成影响,新会话的参数值仍然为修改前的值。

+

+之后,再对global read_buffer_size值进行修改,执行如下命令

+```sql

+set @@global.read_buffer_size = 496 * 1024;

+```

+执行该命令后,sesion和global参数值为

+| @@session.read\_buffer\_size | @@global.read\_buffer\_size |

+| :--- | :--- |

+| 524288 | 507904 |

+

+> `set global xxx`命令只会修改global参数值,对session参数值不会造成影响,新的session其`session参数值, global参数值`和修改后的global参数值保持一致

+

+> 即使针对参数的global值进行了修改,其影响范围是当前实例的整个生命周期,`但是,其并不会对参数文件中的参数值进行修改,故而下次启动mysql实例时,仍然会从参数文件中取值,新实例的值仍然是修改前的值`。

+>

+> 如果想要修改下次启动实例的参数值,需要修改参数文件中该参数的值。(参数文件路径通常为`/etc/my.cnf`)

+

+#### 静态参数修改

+在运行时,如果尝试对静态参数进行修改,那么会发生错误,示例如下:

+```sql

+> set global datadir='/db/mysql'

+[2025-01-30 15:05:17] [HY000][1238] Variable 'datadir' is a read only variable

+```

+## 日志文件

+mysql中常见日志文件如下

+- 错误日志(error log)

+- 二进制日志(binlog)

+- 慢查询日志(slow query log)

+- 查询日志(log)

+

+### 错误日志

+错误日志针对mysql的启动、运行、关闭过程进行了记录,用户可以通过`show variables like 'log_error';`来获取错误日志的路径:

+```sql

+show variables like 'log_error';

+```

+其输出值如下:

+| Variable\_name | Value |

+| :--- | :--- |

+| log\_error | /var/log/mysql/mysqld.log |

+

+当mysql数据库无法正常启动时,应当首先查看错误日志。

+

+### 慢查询日志

+慢查询日志存在一个阈值,通过`long_query_time`参数来进行控制,该参数默认值为`10`,代表慢查询的限制为10s。

+

+通过`slow_query_log`参数,可以控制是否日志输出慢查询日志,默认为`OFF`,如果需要开启慢查询日志,需要将该值设置为`ON`。

+

+关于慢查询日志的输出地点,可以通过`log_output`参数来进行控制。该参数默认为`FILE`,支持`FILE, TABLE, NONE`。`log_output`支持制定多个值,多个值之间可以通过`,`分隔,当值中包含`NONE`时,以`NONE`优先。

+

+#### log_queries_not_using_indexes

+当`log_queryies_not_using_indexes`开启时,如果运行的sql语句没有使用索引,那么这条sql同样会被输出到慢查询日志。该参数默认关闭。

+

+`log_throttle_queries_not_using_idnexes`用于记录`每分钟允许记录到慢查询日志并且没有使用索引`的sql语句次数,该参数值默认为0,代表每分钟输出到慢查询日志中的数量没有限制。

+

+该参数主要用于防止大量没有使用索引的sql添加到慢查询日志中,造成慢查询日志大小快速增加。

+

+当慢查询日志中的内容越来越多时,可以通过mysql提供的工具`mysqldumpslow`命令,示例如下:

+```sql

+mysqldumpslow -s at -n 10 ${slow_query_log_path}

+```

+

+### 查询日志

+查询日志记录了对mysql数据库所有的请求信息,无论请求是否正确执行。

+

+查询日志通过`general_log`参数来进行控制,默认该参数值为`OFF`.

+

+### 二进制日志

+二进制日志(binary log)记录了针对mysql数据库执行的所有更改操作(不包含select以及show这类读操作)。

+

+对于update操作等,即使没有对数据库进行修改(affected rows为0),也会被写入到binary log中。

+

+二进制日志的主要用途如下:

+- 恢复(recovery):某些数据恢复需要二进制日志,例如在数据库全备份文件恢复后,用户可以通过二进制日志进行point-in-time的恢复

+- 复制(replication):通过将一台主机(master)的binlog同步到另一台主机(slave),并且在另一台主机上执行该binlog,可以令slave与master进行实时同步

+- 审计(audit):用户可以对binlog中的信息进行审计,判断是否存在对数据库进行的注入攻击

+

+通过参数`log_bin`可以控制是否启用二进制日志。

+

+binlog通常存放在`datadir`参数所指定的目录路径下。在该路径下,还存在`binlog.index`文件,该文件为binlog的索引文件,文件内容包含所有binlog的文件名称。

+

+#### max_binlog_size

+`max_binlog_size`参数控制单个binlog文件的最大大小,如果单个文件超过该值,会产生新的二进制文件,新binlog的后缀会+1,并且新文件的文件名会被记录到`.index`文件中。

+

+`max_binlog_size`的默认值大小为`1G`。

+

+#### binlog_cache_size

+当使用innodb存储引擎时,所有未提交事务的binlog会被记录到缓存中,等到事务提交后,会将缓存中的binlog写入到文件中。缓存大小通过`binlog_cache_size`决定,该值默认为`32768`,即`32KB`。

+

+`binlog_cache_size`是基于会话的,`在每个线程开启一个事务时,mysql会自动分配一个大小为binlog_cache_size大小的缓存,因而该值不能设置过大`。

+

+当一个事务的记录大于设定的`binlog_cache_size`时,mysql会将缓冲中的日志写入到一个临时文件中,故而,该值无法设置过小。

+

+通过`show global status like 'binlog_cache%`命令可以查看`binlog_cache_use`和`binlog_cache_disk_use`的状态,可以通过上述两个状态判断binlog cache大小是否合适。

+

+##### binlog_cache_use

+`binlog_cache_use`记录了使用缓冲写binlog的次数

+

+##### binlog_cache_disk_use

+`binlog_cache_disk_use`记录了使用临时文件写二进制日志的次数

+

+#### sync_binlog

+`sync_binlog`参数控制mysql server同步binlog到磁盘的频率,该值默认为`1`

+

+- 0: 如果参数值为0,代表mysql server禁用binary log同步到磁盘。mysql会依赖操作系统将binary log刷新到磁盘中,该设置性能最佳,但是遇到操作系统崩溃时,可能会出现mysql事务提交但是还没有同步到binary log的场景

+- 1: 如果参数值设置为1,代表在事务提交之前将binary log同步到磁盘中,该设置最安全,但是会增加disk write次数,对性能会带来负面影响。在操作系统崩溃的场景下,binlog中缺失的事务还只处于prepared状态,从而确保binlog中没有事务丢失

+- N:当参数值被设置为非`0,1`的值时,每当n个binlog commit groups被收集到后,同步binlog到磁盘。在这种情况下,可能会发生事务提交但是还没有被刷新到binlog中,`当n值越大时,性能会越好,但是也会增加数据丢失的风险`

+

+为了在使用innodb事务和replciation时获得最好的一致性和持久性,请使用如下设置:

+```cnf

+sync_binlog=1

+innodb_flush_log_at_trx_commit=1

+```

+

+#### innodb_flush_log_at_trx_commit

+innodb_flush_log_at_trx_commit用于控制redo log的刷新。

+

+该参数用于平衡`commit操作ACID的合规性`以及`更高性能`。通过修改该参数值,可以实现更佳的性能,但是在崩溃时可能会丢失事务:

+- 1: 1为该参数默认值,代表完全的ACID合规性,日志在每次事务提交后被写入并刷新到磁盘中

+- 0: 日志每秒被写入和刷新到磁盘中,如果事务没有被刷新,那么日志将会在崩溃中被丢失

+- 2: 每当事务提交后,日志将会被写入,并且每秒钟都会被刷新到磁盘中。如果事务没有被刷新,崩溃同样会造成日志的丢失

+

+如果当前数据库为slave角色,那么其不会把`从master同步的binlog`写入到自己的binlog中,如果要实现`master=>slave=>slave`的同步架构,必须设置`log_slave_updates`参数。

+

+#### binlog_format

+binlog_format用于控制二进制文件的格式,可能有如下取值:

+- statement: 二进制文件记录的是日志的逻辑sql语句

+- row:记录表的行更改情况,默认值为`row`

+- mixed: 如果参数被配置为mixed,mysql默认会采用`statement`格式进行记录,但是在特定场景能够下会使用`row`格式:

+ - 使用了uuid, user, current_user,found_rows, row_count等不确定函数

+ - 使用了insert delay语句

+ - 使用了用户自定义函数

+ - 使用了临时表

+

+##### 使用statement可能会存在的问题

+在使用statement格式时,可能会存在如下问题

+- master运行rand,uuid等不确定函数时,或使用触发器操作时,会导致主从服务器上的数据不一致

+- innodb的默认事务隔离级别为`repetable_read`,如果使用`read_commited`级别时,statement格式可能会导致丢失更新的情况,从而令master和slave的数据不一致

+

+binlog为动态参数,可以在数据库运行时进行修改,并且可以针对session和global进行修改。

+

+#### mysqlbinlog

+在查看二进制日志时,可以使用`mysqlbinlog`命令,示例如下

+```bash

+mysqlbinlog --start-position=203 ${binlog_path}

+```

+

+## pid文件

+mysql实例启动时,会将进程id写入到一个文件中,该文件被称为pid文件。

+

+pid文件路径通过`pid_file`参数来进行控制,fedora中默认路径为`/run/mysqld/mysqld.pid`。

+

+## 表结构定义文件

+mysql中数据的存储是根据表进行的,每个表都有与之对应的文件。无论表采用何种存储引擎,都会存在一个以`frm`为后缀的文件,该文件中保存了该表的表结构定义。

+

+> mysql 8中,schema对应目录下不再包含frm文件。

+

+## 表空间文件

+innodb采用将存储的数据按照表空间(tablespace)进行存放的设计。在默认配置下,将会有一个初始大小为10MB,名称为ibdata1的文件,该文件为默认的表空间文件。

+

+### innodb_data_file_path

+可以通过`innodb_data_file_path`参数对默认表空间文件进行设置,示例如下:

+```sql

+innodb_data_file_path=datafile_spec1[;datafile_spec2]...

+```

+用户可以通过多个文件组成一个表空间,示例如下:

+```sql

+innodb_data_file_path=/db/ibdata1:2000M;/dr2/db/ibdata2:2000M;autoextend

+```

+在上述配置中,表空间由`/db/ibdata1`和`/dr2/db/ibdata2`两个文件组成,如果两个文件位于不同的磁盘上,那么磁盘的负载将会被平均,数据库的整体性能将会被提高。

+

+同时,在上述示例中,为两个文件都指定了后续属性,含义如下:

+- ibdata1:文件大小为2000M

+- ibdata2:文件大小为2000M,并且当文件大小被用完后,文件会自动增长

+

+当`innodb_data_file_path`被设置后,所有基于innodb存储引擎的表,其数据都会记录到该共享表空间中。

+

+### innodb_file_per_table

+如果`innodb_file_per_table`被启用后(默认启用),则每个基于innodb存储引擎的表都可以有一个独立的表空间,独立表空间的命名规则为`表名+.ibd`。

+

+通过innodb_file_per_table,用户不需要将所有的数据都放置在默认的表空间中。

+

+> `innodb_file_per_table`所产生的独立表空间文件,其仅存储该表的数据、索引和插入缓冲BITMAP信息,其余信息仍然存放在默认的表空间中。

+

+## redo log文件

+redo log是一个基于磁盘的数据结构,用于在crash recovery过程中纠正由`未完成事务写入的错误数据`。

+

+> 在一般操作中,redo log对那些`会造成表数据发生改变的请求`进行encode操作,请求通常由sql statement或地级别api发起。

+

+redo log通常代表磁盘上的redo log file。写入重做日志文件的数据通常基于受影响的记录进行编码。在数据被写入到redo log file中时,LSN值也会不断增加。

+

+### 循环写入

+innodb会按顺序写入redo log文件,例如redo log file group中存在两个文件,innodb会先写文件1,文件1写满后会切换文件2,在文件2写满后,重新切换到文件1。

+

+### redo log capacity

+从mysql 8.0.30开始,`innodb_redo_log_capacity`参数用于控制redo log file占用磁盘空间的大小。该参数可以在实例启动时进行设置,也可以通过`set global`来进行设置。

+

+`innodb_redo_log_capacity`默认值为`104857600`,即`100M`。

+

+redo log文件默认位于`datadir`路径下的`#innodb_redo`目录下。innodb会尝试维护32个redo log file,每个redo log file文件大小都相同,为`1/32 * innodb_redo_log_capacity`。

+

+redo log file将会使用`#ib_redoN`的命名方式,`N`是redo log file number。

+

+innodb redo log file分为如下两种:

+- ordinary:正在被使用的redo log file

+- spare:等待被使用的redo log file

+

+> 相比于ordinary redo log file,spare redo log file的名称中还包含了`_tmp`后缀

+

+每个oridnary redo log file都关联了一个制定的LSN范围,可以通过查询`performance_schema.innodb_redo_log_files`表里获取LSN范围。

+

+示例如下:

+```sql

+select file_name, start_lsn, end_lsn from performance_schema.innodb_redo_log_files;

+```

+查询结果示例如下:

+| file\_name | start\_lsn | end\_lsn |

+| :--- | :--- | :--- |

+| ./#innodb\_redo/#ib\_redo6 | 19656704 | 22931456 |

+

+当执行checkpoint时,innodb会将checkpoint LSN存储在文件的header中,在recovery过程中,所有的redo log文件都将被检查,并且基于最大的LSN来执行恢复操作。

+

+常用的redo log状态如下

+```bash

+ # resize operation status

+ Innodb_redo_log_resize_status

+ # 当前redo log capacity

+ Innodb_redo_log_capacity_resized

+ Innodb_redo_log_checkpoint_lsn

+ Innodb_redo_log_current_lsn

+ Innodb_redo_log_flushed_to_disk_lsn

+ Innodb_redo_log_logical_size

+ Innodb_redo_log_physical_size

+ Innodb_redo_log_read_only

+ Innodb_redo_log_uuid

+```

+> 重做日志大小设置时,如果设置大小过大,那么在执行恢复操作时,可能需要花费很长时间;如果重做日志文件大小设置过小,可能会导致事务的日志需要多次切换重做日志文件。

+>

+> 此外,重做日志太小会频繁发生async checkpoint,导致性能抖动。重做日志存在一个capacity,代表了最后的checkpoint不能够超过这个阈值,如果超过必须将缓冲区中的部分脏页刷新到磁盘中,此时可能会造成用户线程的阻塞。

+

+### redo log和binlog的区别

+#### 记录内容

+binlog记录的是一个事务的具体操作内容,该日志为逻辑日志。

+

+而innodb redo log记录的是关于某个页的修改,为物理日志。

+

+#### 写入时机

+binlog仅当事务提交前才进行提交,即只会写磁盘一次。

+

+redo log则是在事务运行过程中,不断有重做日志被写入到redo log file中。

+

+### redo log写入时机

+- master thread会每秒将redo log从buffer中刷新到redo log ile中,不露内事务是否已经提交

- innodb_flush_log_at_trx_commit控制redo log的刷新时机,默认情况下,在事务提交前会将数据从redo log buffer刷新到redo log file中

\ No newline at end of file

diff --git a/mysql/mysql文档/mysql_表.md b/mysql/mysql文档/mysql_表.md

index ea737b3..96d2e25 100644

--- a/mysql/mysql文档/mysql_表.md

+++ b/mysql/mysql文档/mysql_表.md

@@ -1,713 +1,713 @@

-- [表](#表)

- - [索引组织表](#索引组织表)

- - [innodb逻辑存储结构](#innodb逻辑存储结构)

- - [表空间](#表空间)

- - [innodb\_file\_per\_table](#innodb_file_per_table)

- - [段(segment)](#段segment)

- - [区(Extent)](#区extent)

- - [页(Page)](#页page)

- - [行](#行)

- - [innodb行记录格式](#innodb行记录格式)

- - [Compact](#compact)

- - [变长字段长度列表](#变长字段长度列表)

- - [NULL标志位](#null标志位)

- - [记录头信息](#记录头信息)

- - [行溢出数据](#行溢出数据)

- - [dynamic](#dynamic)

- - [char存储结构](#char存储结构)

- - [innodb数据页结构](#innodb数据页结构)

- - [File Header](#file-header)

- - [Infimum和Supremum record](#infimum和supremum-record)

- - [user record 和 free space](#user-record-和-free-space)

- - [page directory](#page-directory)

- - [B+树索引](#b树索引)

- - [File Trailer](#file-trailer)

- - [完整性校验](#完整性校验)

- - [分区表](#分区表)

- - [partition keys \& primary keys \& unique keys](#partition-keys--primary-keys--unique-keys)

- - [表中不存在唯一索引](#表中不存在唯一索引)

- - [后续向分区表添加唯一索引](#后续向分区表添加唯一索引)

- - [对非分区表进行分区](#对非分区表进行分区)

- - [分区类型](#分区类型)

- - [RANGE](#range)

- - [information\_schema.partitions](#information_schemapartitions)

- - [看select语句查询了哪些分区](#看select语句查询了哪些分区)

- - [插入超过分区范围的数据](#插入超过分区范围的数据)

- - [向分区表中添加分区](#向分区表中添加分区)

- - [向分区表中删除分区](#向分区表中删除分区)

- - [LIST](#list)

- - [HASH](#hash)

- - [新增HASH分区](#新增hash分区)

- - [减少HASH分区](#减少hash分区)

- - [LINEAR HASH](#linear-hash)

- - [KEY \& LINEAR KEY](#key--linear-key)

- - [COLUMNS](#columns)

- - [range columns](#range-columns)

- - [list columns](#list-columns)

- - [子分区](#子分区)

- - [分区中的NULL值](#分区中的null值)

- - [分区和性能](#分区和性能)

- - [不分区](#不分区)

- - [按id进行分区](#按id进行分区)

- - [在表和分区之间交换数据](#在表和分区之间交换数据)

-

-

-# 表

-## 索引组织表

-innodb存储引擎中,表都是根据主键顺序组织存放的,这种存储方式被称为索引组织表(index organized table)。在innodb存储引擎表中,每张表都有主键(primary key),如果在创建表时没有显式指定主键,那么innodb会按照如下方式创建主键:

-- 首先判断表中是否存在非空的唯一索引(unique not null)字段,如果有,则其为主键

-- 如果不存在非空唯一索引,那么innodb会自动创建一个6字节大小的指针作为主键

-

-如果有多个非空唯一索引,innodb存储引擎将会选择第一个定义的非空唯一索引作为主键。

-

-## innodb逻辑存储结构

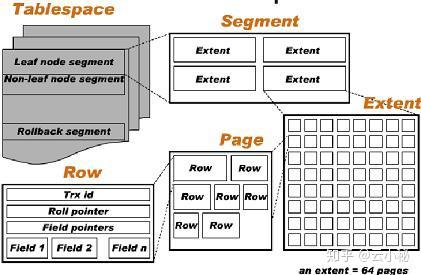

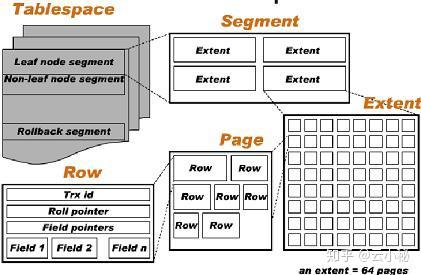

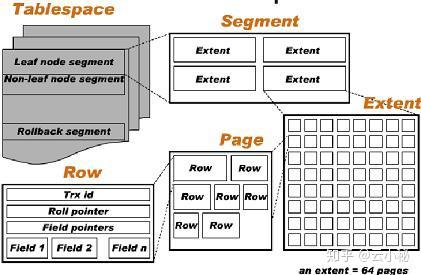

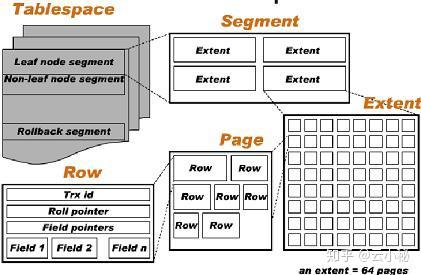

-在innodb的存储逻辑结构中,所有的数据都被逻辑存放在表空间(table space)中。表空间则由`段(segement),区(extent),页(page)`组成。

-

-组成如图所示:

-

-

+

+如上图所示,HTTP/2和HTTP/3在传输多个资源时,都只创建了一个连接。但是,QUIC中不同byte streams是独立传输的,拥有不同的传输路径,并且不同byte streams之间不会彼此阻塞。

+

+即使QUIC解决了HTTP/2中引入的HOL问题,乱序传输也会存在弊端:byte streams并不会按照其被发送的顺序到达。例如,在使用乱序传输时,最不重要的资源可能会最先到达。

+

+#### Flexible Bandwidth Management

+带宽管理用于在packets和streams之间按照最优的方式对网络带宽进行分配。这是至关重要的功能,发送方和接收方的机器以及二者之间的网络节点处理packets的速度都有所不同,并且速度也会动态变化。

+

+带宽管理有助于避免网络中的数据溢出和拥塞,这些问题可能会导致server响应速度变慢,同时也可能会带来安全问题。

+

+UDP中并没有内置带宽控制,QUIC则是在HTTP3协议栈中负责该功能,其对TCP带宽管理中的两大部分进行了重新实现:

+- 流控制: 其在接收方限制了数据发送的速率,用于避免发送方造成接收方过载

+- 拥塞控制:其限制了发送方和接收方之间的路径中每一个节点的发送速率,用于避免网络拥塞

+

+##### Pre-Stream Flow Control

+为了支持独立的stream,QUIC采用了per-stream based flow control。其在两个级别控制了stream data的带宽消耗:

+- 对于每个独立的流,都设置了一个可分配给其的最大数据数量

+- 在整个连接范的围内,设置了active streams最大的累积数量

+

+通过per-stream flow control,QUIC限制了同时可以发送的数据数量,用于避免接收方过载,并且在多个streams间大致公平的分配网络容量。

+

+##### 拥塞控制算法

+QUIC允许实现选择不同的拥塞控制算法,使用最广泛的算法如下:

+- NewReno:TCP使用的拥塞控制算法

+- CUBIC: 和NewReno类似,但是使用了cubic function而不是linear function

+- BBR

+

+在网络状况较差的场景下,不同的拥塞控制算法性能可能存在较大差异。

+

diff --git a/java se/垃圾回收和引用.md b/java se/垃圾回收和引用.md

index 70c62c9..dd9b2a9 100644

--- a/java se/垃圾回收和引用.md

+++ b/java se/垃圾回收和引用.md

@@ -1,109 +1,109 @@

-- [垃圾回收和引用](#垃圾回收和引用)

- - [finalize](#finalize)

- - [引用](#引用)

- - [Reference](#reference)

- - [get](#get)

- - [clear](#clear)

- - [enqueue](#enqueue)

- - [isEnqueue](#isenqueue)

- - [引用的可达性](#引用的可达性)

- - [强可达(strongly reachable)](#强可达strongly-reachable)

- - [软可达(softly reachable)](#软可达softly-reachable)

- - [弱可达(weakly reachable)](#弱可达weakly-reachable)

- - [终结器可达(finalizer reachable)](#终结器可达finalizer-reachable)

- - [幽灵可达(phantom reachable)](#幽灵可达phantom-reachable)

- - [引用类型](#引用类型)

- - [软引用(SoftReference)](#软引用softreference)

- - [弱引用(WeakReference)](#弱引用weakreference)

- - [幽灵可达](#幽灵可达)

- - [Weak Hash Map](#weak-hash-map)

- - [引用队列](#引用队列)

- - [ReferenceQueue.poll](#referencequeuepoll)

- - [ReferenceQueue.remove](#referencequeueremove)

- - [弱引用和软引用的使用](#弱引用和软引用的使用)

-

-# 垃圾回收和引用

-## finalize

-finalize方法将会在对象的空间被回收之前被调用。如果一个对象被垃圾回收器判为不可达而需要被回收时,垃圾回收器将调用该对象的finalize方法,通过finalize方法可以清除对象的一些非内存资源。

-在每个对象中,finalize方法最多被调用一次。

-> finalize方法可以抛出任何异常,但是抛出的异常将被垃圾回收器忽略。

-

-在finalize方法调用时,该对象引用的其他对象可能也是垃圾对象,并且已经被回收。

-## 引用

-### Reference

-Reference是一个抽象类,是所有特定引用类的父类。

-#### get

-```java

-public Object get()

-```

-将会返回引用对象指向的被引用对象

-#### clear

-```java

-public void clear()

-```

-清空引用对象从而使其不指向任何对象

-#### enqueue

-```java

-public boolean enqueue()

-```

-如果存在引用对象,将引用对象加入到注册的引用队列中,如果加入队列成功,返回true;如果没有成功加入到队列,或者该引用对象已经在队列中,那么返回false

-#### isEnqueue

-```java

-public boolean isEnqueue()

-```

-如果该引用对象已经被加入到引用队列中,那么返回true,否则返回false

-### 引用的可达性

-#### 强可达(strongly reachable)

-至少通过一条强引用链可达

-#### 软可达(softly reachable)

-不是强可达,但是至少可以通过一条包含软引用的引用链可达

-#### 弱可达(weakly reachable)

-不是弱可达,但是至少通过一条包含弱引用的引用链可达

-#### 终结器可达(finalizer reachable)

-不是弱可达,但是该对象的finalize方法尚未执行

-#### 幽灵可达(phantom reachable)

-如果finalize方法已经执行,但是可通过至少一条包含幽灵引用的引用链可达

-### 引用类型

-#### 软引用(SoftReference)

-对于软可达的对象,垃圾回收程序会随意进行处置,如果可用内存很低,回收器会清空SoftReference对象中的引用,之后该被引用对象则能被回收

-> 在抛出OOM之前,所有的SoftReference引用将会被清空

-

-#### 弱引用(WeakReference)

-弱可达对象将会被垃圾回收器回收,如果垃圾回收器认为对象是弱可达的,所有指向其的WeakReference对象都会被清空

-

-#### 幽灵可达

-幽灵可达并不是真正的可达,虚引用并不会影响对象的生命周期,如果一个对象和虚引用关联,则该对象跟没有与该虚引用关联一样,在任何时候都有可能被垃圾回收。虚引用主要用于跟踪对象垃圾回收的活动。

-

-### Weak Hash Map

-WeakHashMap会使用WeakReference来存储key。

-如果垃圾回收器发现一个对象弱可达时,会将弱引用放入到引用队列中。WeakHashMap会定期检查引用队列中新到达的弱引用,并且新到的弱引用代表该key不再被使用,WeakHashMap会移除关联的entry。

-

-

-### 引用队列

-如果对象的可达性状态发生了改变,那么执行该对象的引用类型将会被放置到引用队列中。引用队列通常被垃圾回收器使用。

-也可以在自己的代码中对引用队列进行使用,通过引用队列,可以监听对象的可达性改变。

-> 例如当对象不再被强引用,变为弱可达时,引用将会被添加到引用队列中,再通过代码监听引用队列的变化,即可监听到对象可达性的变化

-

-> ReferenceQueue是线程安全的。

-

-#### ReferenceQueue.poll

-```java

-pulbic Reference poll()

-```

-该方法会删除并且返回队列中的下一个引用对象,若队列为空,则返回值为null

-

-#### ReferenceQueue.remove

-```java

-public Reference remove() throws InterruptedException

-```

-该方法同样会删除并返回队列中下一个引用对象,但是该方法在队列为空时会无限阻塞下去

-```java

-public Reference remove(long timeout) throws InterruptedException

-```

-

-引用对象在构造时,会和特定的引用队列相关联,当被引用对象的可达性状态发生变化时,被添加到引用队列中。在被添加到队列之前,引用对象都已经被清空。

-

-### 弱引用和软引用的使用

-弱引用和软引用都提供两种类型的构造函数,

-- 只接受被引用对象,并不将引用注册到引用队列

+- [垃圾回收和引用](#垃圾回收和引用)

+ - [finalize](#finalize)

+ - [引用](#引用)

+ - [Reference](#reference)

+ - [get](#get)

+ - [clear](#clear)

+ - [enqueue](#enqueue)

+ - [isEnqueue](#isenqueue)

+ - [引用的可达性](#引用的可达性)

+ - [强可达(strongly reachable)](#强可达strongly-reachable)

+ - [软可达(softly reachable)](#软可达softly-reachable)

+ - [弱可达(weakly reachable)](#弱可达weakly-reachable)

+ - [终结器可达(finalizer reachable)](#终结器可达finalizer-reachable)

+ - [幽灵可达(phantom reachable)](#幽灵可达phantom-reachable)

+ - [引用类型](#引用类型)

+ - [软引用(SoftReference)](#软引用softreference)

+ - [弱引用(WeakReference)](#弱引用weakreference)

+ - [幽灵可达](#幽灵可达)

+ - [Weak Hash Map](#weak-hash-map)

+ - [引用队列](#引用队列)

+ - [ReferenceQueue.poll](#referencequeuepoll)

+ - [ReferenceQueue.remove](#referencequeueremove)

+ - [弱引用和软引用的使用](#弱引用和软引用的使用)

+

+# 垃圾回收和引用

+## finalize

+finalize方法将会在对象的空间被回收之前被调用。如果一个对象被垃圾回收器判为不可达而需要被回收时,垃圾回收器将调用该对象的finalize方法,通过finalize方法可以清除对象的一些非内存资源。

+在每个对象中,finalize方法最多被调用一次。

+> finalize方法可以抛出任何异常,但是抛出的异常将被垃圾回收器忽略。

+

+在finalize方法调用时,该对象引用的其他对象可能也是垃圾对象,并且已经被回收。

+## 引用

+### Reference

+Reference是一个抽象类,是所有特定引用类的父类。

+#### get

+```java

+public Object get()

+```

+将会返回引用对象指向的被引用对象

+#### clear

+```java

+public void clear()

+```

+清空引用对象从而使其不指向任何对象

+#### enqueue

+```java

+public boolean enqueue()

+```

+如果存在引用对象,将引用对象加入到注册的引用队列中,如果加入队列成功,返回true;如果没有成功加入到队列,或者该引用对象已经在队列中,那么返回false

+#### isEnqueue

+```java

+public boolean isEnqueue()

+```

+如果该引用对象已经被加入到引用队列中,那么返回true,否则返回false

+### 引用的可达性

+#### 强可达(strongly reachable)

+至少通过一条强引用链可达

+#### 软可达(softly reachable)

+不是强可达,但是至少可以通过一条包含软引用的引用链可达

+#### 弱可达(weakly reachable)

+不是弱可达,但是至少通过一条包含弱引用的引用链可达

+#### 终结器可达(finalizer reachable)

+不是弱可达,但是该对象的finalize方法尚未执行

+#### 幽灵可达(phantom reachable)

+如果finalize方法已经执行,但是可通过至少一条包含幽灵引用的引用链可达

+### 引用类型

+#### 软引用(SoftReference)

+对于软可达的对象,垃圾回收程序会随意进行处置,如果可用内存很低,回收器会清空SoftReference对象中的引用,之后该被引用对象则能被回收

+> 在抛出OOM之前,所有的SoftReference引用将会被清空

+

+#### 弱引用(WeakReference)

+弱可达对象将会被垃圾回收器回收,如果垃圾回收器认为对象是弱可达的,所有指向其的WeakReference对象都会被清空

+

+#### 幽灵可达

+幽灵可达并不是真正的可达,虚引用并不会影响对象的生命周期,如果一个对象和虚引用关联,则该对象跟没有与该虚引用关联一样,在任何时候都有可能被垃圾回收。虚引用主要用于跟踪对象垃圾回收的活动。

+

+### Weak Hash Map

+WeakHashMap会使用WeakReference来存储key。

+如果垃圾回收器发现一个对象弱可达时,会将弱引用放入到引用队列中。WeakHashMap会定期检查引用队列中新到达的弱引用,并且新到的弱引用代表该key不再被使用,WeakHashMap会移除关联的entry。

+

+

+### 引用队列

+如果对象的可达性状态发生了改变,那么执行该对象的引用类型将会被放置到引用队列中。引用队列通常被垃圾回收器使用。

+也可以在自己的代码中对引用队列进行使用,通过引用队列,可以监听对象的可达性改变。

+> 例如当对象不再被强引用,变为弱可达时,引用将会被添加到引用队列中,再通过代码监听引用队列的变化,即可监听到对象可达性的变化

+

+> ReferenceQueue是线程安全的。

+

+#### ReferenceQueue.poll

+```java

+pulbic Reference poll()

+```

+该方法会删除并且返回队列中的下一个引用对象,若队列为空,则返回值为null

+

+#### ReferenceQueue.remove

+```java

+public Reference remove() throws InterruptedException

+```

+该方法同样会删除并返回队列中下一个引用对象,但是该方法在队列为空时会无限阻塞下去

+```java

+public Reference remove(long timeout) throws InterruptedException

+```

+

+引用对象在构造时,会和特定的引用队列相关联,当被引用对象的可达性状态发生变化时,被添加到引用队列中。在被添加到队列之前,引用对象都已经被清空。

+

+### 弱引用和软引用的使用

+弱引用和软引用都提供两种类型的构造函数,

+- 只接受被引用对象,并不将引用注册到引用队列

- 既接受被引用对象,还将引用注册到指定的引用队列,然后可以通过检查引用队列中的情况来监听被引用对象可达状态变更

\ No newline at end of file

diff --git a/mysql/mysql文档/mysql_文件.md b/mysql/mysql文档/mysql_文件.md

index 043490e..d7b5d3d 100644

--- a/mysql/mysql文档/mysql_文件.md

+++ b/mysql/mysql文档/mysql_文件.md

@@ -1,363 +1,363 @@

-- [文件](#文件)

- - [参数](#参数)

- - [参数查看](#参数查看)

- - [参数类型](#参数类型)

- - [动态参数修改](#动态参数修改)

- - [静态参数修改](#静态参数修改)

- - [日志文件](#日志文件)

- - [错误日志](#错误日志)

- - [慢查询日志](#慢查询日志)

- - [log\_queries\_not\_using\_indexes](#log_queries_not_using_indexes)

- - [查询日志](#查询日志)

- - [二进制日志](#二进制日志)

- - [max\_binlog\_size](#max_binlog_size)

- - [binlog\_cache\_size](#binlog_cache_size)

- - [binlog\_cache\_use](#binlog_cache_use)

- - [binlog\_cache\_disk\_use](#binlog_cache_disk_use)

- - [sync\_binlog](#sync_binlog)

- - [innodb\_flush\_log\_at\_trx\_commit](#innodb_flush_log_at_trx_commit)

- - [binlog\_format](#binlog_format)

- - [使用statement可能会存在的问题](#使用statement可能会存在的问题)

- - [mysqlbinlog](#mysqlbinlog)

- - [pid文件](#pid文件)

- - [表结构定义文件](#表结构定义文件)

- - [表空间文件](#表空间文件)

- - [innodb\_data\_file\_path](#innodb_data_file_path)

- - [innodb\_file\_per\_table](#innodb_file_per_table)

- - [redo log文件](#redo-log文件)

- - [循环写入](#循环写入)

- - [redo log capacity](#redo-log-capacity)

- - [redo log和binlog的区别](#redo-log和binlog的区别)

- - [记录内容](#记录内容)

- - [写入时机](#写入时机)

- - [redo log写入时机](#redo-log写入时机)

-

-

-# 文件

-## 参数

-### 参数查看

-mysql参数为键值对,可以通过`show variables`命令查看所有的数据库参数,并可以通过`like`来过滤参数名称。

-

-除了`show variables`命令之外,还能够在`performance_schema`下的`global_variables`视图来查找数据库参数,示例如下:

-```sql

--- 查看innodb_buffer_pool_size参数

-show variables like 'innodb_buffer_pool_size'

-```

-上述`show variables`命令的执行结果为

-| Variable\_name | Value |

-| :--- | :--- |

-| innodb\_buffer\_pool\_size | 4294967296 |

-

-```sql

-select * from performance_schema.global_variables where variable_name like 'innodb_buffer_pool%';

-```

-上述sql的执行结果如下:

-| VARIABLE\_NAME | VARIABLE\_VALUE |

-| :--- | :--- |

-| innodb\_buffer\_pool\_chunk\_size | 134217728 |

-| innodb\_buffer\_pool\_dump\_at\_shutdown | ON |

-| innodb\_buffer\_pool\_dump\_now | OFF |

-| innodb\_buffer\_pool\_dump\_pct | 25 |

-| innodb\_buffer\_pool\_filename | ib\_buffer\_pool |

-| innodb\_buffer\_pool\_in\_core\_file | ON |

-| innodb\_buffer\_pool\_instances | 4 |

-| innodb\_buffer\_pool\_load\_abort | OFF |

-| innodb\_buffer\_pool\_load\_at\_startup | ON |

-| innodb\_buffer\_pool\_load\_now | OFF |

-| innodb\_buffer\_pool\_size | 4294967296 |

-

-### 参数类型

-mysql中的参数可以分为`动态`和`静态`两种类型,

-- 动态:动态参数代表可以在mysql运行过程中进行修改

-- 静态:代表在整个实例的声明周期内都不得进行修改

-

-#### 动态参数修改

-对于动态参数,可以在运行时通过`SET`命令来进行修改,`SET`命令语法如下:

-```sql

-set

- | [global | session] system_var_name=expr

- | [@@global. | @@session. | @@] system_var_name = expr

-```

-在上述语法中,`global`和`session`关键字代表该动态参数的修改是针对`当前会话`还是针对`整个实例的生命周期`。

-